«هوش مصنوعی» (AI) و «مدلهای زبانی بزرگ» (LLM) به یکی از مهمترین عناصر فناوری کنونی تبدیل شدهاند. کاربرد چنین فناوریهای هوشمندی را در زمینههای گوناگون، از «پردازش زبان طبیعی گرفته» (NLP) تا تحلیل پیشگویانه و سیستمهای خودگردان میتوان مشاهده کرد. با پیشرفت هوش مصنوعی و گسترش بهکارگیری آن در صنایع گوناگون، توانایی توسعه و ساخت اپلیکیشن بر مبنای این فناوری به مهارتی بسیار ارزشمند برای برنامهنویسان و مهندسان تبدیل شده است. در همین راستا این مطلب از مجله فرادرس را به تشریح مجموعهابزارهای ضروری برای توسعه برنامههای مجهز به هوش مصنوعی و مدلهای بزرگ زبانی اختصاص دادهایم.

اگر به ساخت برنامههای مبتنی بر هوش مصنوعی و LLM علاقهمند هستید، این نوشتار میتواند نقش راهنمای ساده و سودمندی را برای شما ایفا کند. در این مطلب، با مجموعهای از مهمترین ابزارها و فناوریهای توسعه و همچنین دانش مقدماتی لازم برای شروع، آشنا خواهید شد. فرقی نمیکند فردی مبتدی باشید که به دنبال نقشه راهی برای شروع یادگیری است، یا توسعهدهندهای با تجربه که قصد تقویت مهارتهای خود را دارد، در هر صورت، مطالعه این راهنما میتواند برایتان بسیار مفید باشد.

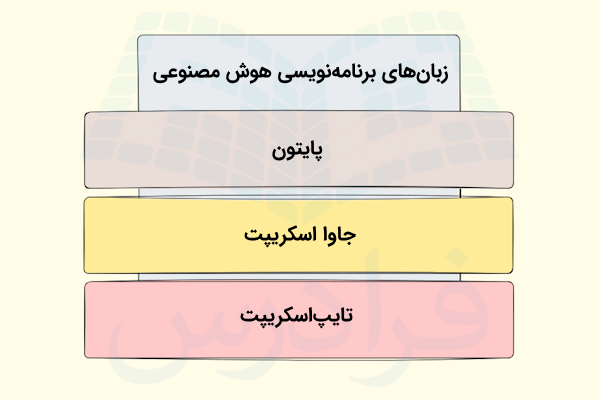

زبان های برنامه نویسی

اگر شما هم به توسعه برنامههای مبتنی بر AI و LLM علاقهمند هستید، لازم است زبان برنامهنویسی مناسب برای این کار را انتخاب کنید. برخی از زبانها از جمله پایتون، جاوا اسکریپت، تایپاسکریپت و غیره به دلیل داشتن ویژگیهایی همچون سادگی، سرعت بالا و داشتن کتابخانهها و ابزارهای متنوع، بهطور گستردهای در این زمینه استفاده میشوند و محبوبیت بیشتری بین افراد دارند.

در این قسمت، برخی از محبوبترین زبانهای برنامهنویسی که استفاده از آنها در ساخت برنامههای هوش مصنوعی و مدلهای بزرگ زبانی رایجتر است را به شما معرفی کردهایم.

پایتون

هنگامیکه صحبت از ساخت برنامههای مبتنی بر هوش مصنوعی میشود، بدون شک، پایتون یکی از محبوبترین گزینههایی است که با آن رو به رو خواهید شد. زبان پایتون، سینتکس سادهای دارد و کدهای آن به دلیل خوانایی بالا، به راحتی قابل درک هستند. این ویژگیها باعث میشود تا افراد مبتدی بهراحتی بتوانند آن را یاد بگیرند.

دلیل دیگر محبوبیت این زبان، کتابخانهها و فریمورکهای فراوانی است که برای آن وجود دارد. این ویژگی، به برنامهنویسان باتجربه امکان میدهد تا اپلیکیشنهای پیشرفته مبتنی بر هوش مصنوعی را با سرعت بیشتری پیادهسازی کنند. پایتون در زمینه یادگیری ماشین، یادگیری عمیق و تحلیل دادهها، ابزارهای بسیار ارزشمندی را از طریق کتابخانههایی همچون موارد زیر در اختیارتان قرار میدهد.

- TensorFlow

- Pytoch

- Scikit Learn

علاوه بر مزایای اشاره شده، انعطافپذیری این زبان باعث میشود تا بتوان از آن در زمینههای گوناگون هوش مصنوعی و پیادهسازی برنامههای مختلفی از جمله پردازش زبان طبیعی، بینایی کامپیوتر و غیره بهره برد.

جاوا اسکریپت

جاوا اسکریپت یا به اختصار «JS» زبان محبوب دیگری است که برای توسعه برنامههای هوش مصنوعی مورد استفاده قرار میگیرد. به بیان دیگر، به کمک این زبان میتوانید قابلیتهای هوش مصنوعی را در وباپلیکیشنهای خود پیادهسازی کنید. کدها و برنامههای نوشته شده با زبان جاوا اسکریپت میتوانند درون مرورگر وب اجرا شوند. این ویژگی، JS را به یکی از بهترین زبانها برای توسعه قابلیتهای تعاملی مبتنی بر هوش مصنوعی در وبسایتها تبدیل کرده است.

از ابزارهای این زبان در زمینه هوش مصنوعی میتوان به کتابخانه «TensorFlow.js» اشاره کرد. این ابزار کمک میکند تا بدون کدنویسی سمت سرور، بتوان مدلهای یادگیری ماشین را درون مرورگر آموزش داد و اجرا کرد. بدینترتیب میتوانیم دادهها را بهصورت بیدرنگ پردازش کنیم.

تایپ اسکریپت

زبان تایپاسکریپت، نسخهای توسعه یافته از JS بهشمار میرود و از ویژگی «نوعدهی ایستا» (Static Typing) نیز پشتیبانی میکند. یعنی لازم است نوع دادهها را پیش از اجرای برنامه مشخص کنید. با انجام این کار، برنامهنویس در هنگام نوشتن برنامه و حین توسعه آن میتواند خطاهای احتمالی را شناسایی کند. در نهایت نیز برنامه شما کدهای بهتر و پایدارتری خواهد داشت. ضمن اینکه تغییر و نگهداری از آنها نیز راحتتر قابل خواهد بود.

در زمینه ساخت برنامههای مبتنی بر هوش مصنوعی با تایپ اسکریپت، «امنیت نوع» (Type Safety) فراهم شده توسط این زبان باعث میشود تا خطاهای زمان اجرا کاهش یافته و ساختارهای دادهای موجود در برنامه انسجام بیشتری داشته باشد.

لازم است اشاره کنیم که تایپاسکریپت سازگاری بالایی با JS دارد. به همیندلیل، برنامهنویسان میتوانند به مرور و بدون اینکه نیاز به تغییرات گستردهای باشد، این زبان را در پروژههای پیشین خود نیز استفاده کنند.

اگر به دنبال پاسخی برای این پرسش هستید که بهترین زبان برای توسعه اپلیکیشنهای AI کدام است، باید بگوییم که این موضوع به نوع پروژه شما و نیازهای اپلیکیشن مورد نظر بستگی دارد. میزان مهارت کدنویسی شما در هر یک از این زبانها نیز در این مورد مؤثر است. بهطور کلی، میتوان گفت درصورتیکه اپلیکیشن شما با دادههای فراوانی سر و کار دارد، پایتون میتواند انتخاب بهتری باشد. JS و تایپاسکریپت نیز برای توسعه برنامههای آنلاین و مبتنی بر وب مناسب هستند.

مدل های هوش مصنوعی و LLM ها

بسیاری از اپلیکیشنهای مبتنی بر هوش مصنوعی که این روزها به آنها دسترسی داریم دارای مؤلفه بسیار مهمی به نام «مدل بزرگ زبانی» (Large Language Model | LLMs) در درون خود هستند که در انجام کارهایی مانند تولید محتوای متنی، ترجمه و خلاصهسازی متون و غیره نقش دارند.

در حال حاضر، LLM-هایی را میتوانید پیدا کنید که توسط شرکتهای گوناگونی عرضه شدهاند. هر یک این ابزارها ویژگیها و مزایای خاص خود را به همراه دارند. جدول زیر فهرستی از مهمترین مدلهای بزرگ زبانی را به شما نشان میدهد که دانستن آن برایتان مفید خواهد بود.

| مدل بزرگ زبانی | عرضه کننده |

| مدل های GPT | OpenAI |

| جمنای | گوگل |

| Llama | متا |

| Claude | آنتروپیک |

| Grok | xAI |

| R1 | دیپسیک |

| Command | Cohere |

| StableLM | Stability AI |

مدل های GPT از شرکت OpenAI

نخستین LLM که در اینجا معرفی میکنیم «ترنسفورمر از پیش آموزش دیده مولد» یا «جیپیتی» (Generative Pre-trained Transformer | GPT) نام دارد که توسط شرکت «OpenAI» عرضه شده است. استفاده از این مدلها برای انجام کارهای مربوط به حوزه پردازش زبان طبیعی بسیار متداول است. جدیدترین نسخههای این مدل با دانش بیشتر خود، پاسخهای دقیقتری را در مقایسه با نسخههای قدیمیتر ارائه میدهند. ضمن اینکه میزان خطاها و اشتباهات آنها نیز کمتر شده است.

برنامهنویسان از طریق API-های فراهم شده توسط OpenAI میتوانند به مدلهای عرضه شده توسط این شرکت دسترسی داشته باشند.

- لینک دسترسی به وبسایت OpenAI: «+»

مدل Gemini از شرکت گوگل

LLM پیشرفته و قدرتمند دیگری که معرفی میکنیم، «جمنای» نام دارد. مدلی که توسط شرکت گوگل عرضه شده و توانایی انجام بسیاری از کارهای مرتبط با هوش مصنوعی را دارد. جمنای زبان طبیعی ما انسانها را بهخوبی درک کرده و میتواند پاسخهای مناسبی را برایمان تولید کند.

این مدل در پلتفرمها و سرویسهای گوناگون گوگل استفاده شده و همین مورد آن را در تولید پاسخهای مناسب و دقیقتر یاری میدهد.

- لینک دسترسی به Gemini: «+»

مدل Llama عرضه شده توسط متا

لاما، نام مدل زبانی دیگری است که توسط شرکت متا یا فیسبوک سابق و با هدف دسترسی راحتتر پژوهشگران و برنامهنویسان به قابلیتهای هوش مصنوعی عرضه شده است. اگر قصد تولید برنامههای هوش مصنوعی بدون استفاده از مدلهای انحصاری و «منبع-بسته» را دارید، «Llama» میتواند انتخاب بسیار قدرتمند و مناسبی برایتان باشد. ضمن اینکه سرعت مناسب و عملکرد بالایی را نیز ارائه میدهد.

- لینک دسترسی به وبسایت لاما: «+»

مدل Claude محصول شرکت آنتروپیک

شرکت استارتآپی آنتروپیک، مدل زبانی قدرتمندی به نام «Claude» را عرضه کرده است که قدرت استدلال بالایی در تولید پاسخها دارد. این ابزار همچنین انعطافپذیری خوبی از خود نشان میدهد و بسته به نیاز شما میتواند پاسخهای سریع یا توضیحات مفصل و گامبهگام را برایتان تولید کند. همین خصوصیات باعث شده تا Claude در انجام کارهای متنوعی همچون کدنویسی یا حل مسائل بسیار سودمند باشد.

- لینک دسترسی به Claude: «+»

مدل Grok از شرکت xAI

شرکت متعلق به ایلانماسک یعنی «xAI»، مدل هوش مصنوعی «گِراک» (Grok) را عرضه کرده که با تولید پاسخهایی هوشمند و مرتبط با موقعیت، تعاملات کاربران در پلتفرمهایی نظیر «ایکس» (X) یا توییتر سابق بهبود میدهد.

- لینک دسترسی به Grok: «+»

مدل DeepSeek-R1

شرکت چینی «DeepSeek» در اواخر سال ۱۴۰۳ شمسی مدل بزرگ زبانی خود یعنی «DeepSeek-R1» را عرضه کرد. از مهمترین خصوصیات این مدل میتوان به کارآیی بالای آن اشاره کرد. ضمن اینکه در مقایسه با سایر مدلهای شناخته شده، به منابع محاسباتی کمتری نیاز دارد.

نکته دیگری که در مورد DeepSeek-R1 وجود دارد این است که با هدف کاهش مداخلات انسانی در حین آموزش، از روشهای نوین یادگیری تقویتی بهره میبرد.

- لینک دسترسی به DeepSeek: «+»

Command از Cohere

مجموعه مدلهای زبانی «Command»، توسط شرکت «Cohere» و با هدف استفاده در سازمانها عرضه شدهاند. سازمانها میتوانند این مدلها بر مبنای نیازهای خود سفارشیسازی کنند. ضمن اینکه توسعهپذیر بودن این مدلها، امکان استفاده از آنها در مقیاسها بزرگتر را نیز فراهم میکند. مجموع این ویژگیها باعث میشوند تا LLM-های Command گزینه مناسبی برای شرکتها باشند تا بهوسیله آن از فناوری هوش مصنوعی و قابلیتهای شگفتانگیز آن در کارهای خود استفاده کنند.

- لینک دسترسی به Command: «+»

StableLM از Stability AI

StableLM به مجموعهای از مدلهای زبانی اشاره دارد که سعی در فراهم کردن عملکردی قابل اعتماد و پایدار دارند. این دسته از LLM-ها که توسط شرکت «Stability AI» عرضه شدهاند در شرایط و کاربردهای گوناگون، عملکرد یکپارچه و یکنواختی را از خود به نمایش میگذارند. به همین دلیل میتوانند انتخاب مناسبی برای برنامهنویسان باشند.

- لینک دسترسی به StableLM: «+»

در این قسمت، با مدلهای بزرگ زبانی و همچنین عرضهکنندگان آنها آشنا شدید که ابزارهای گوناگونی را برای توسعه اپلیکیشنهای مبتنی بر هوش مصنوعی در اختیار شما قرار میدهند. آشنایی با ویژگیها و قابلیتهای هر یک از این LLM-ها به شما کمک میکند تا مدل مناسب برای پروژه و اپلیکیشن خود را انتخاب کنید.

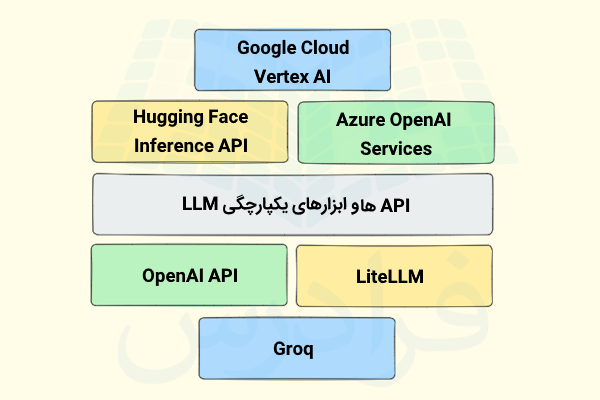

API ها و ابزارهای یکپارچگی LLM

برای اینکه بتوانید از مزایای یک LLM در اپلیکیشن خود بهرهمند شوید، لازم است با استفاده از API-های فراهم شده به آنها متصل شوید. در واقع API-ها راههای ارتباطی با مدلهای بزرگ زبانی بهشمار میآیند و حتی اگر خودتان این مدلها را میزبانی کرده باشید، باز هم برای تعامل با آنها لازم است از این شیوه استفاده کنید. بهکمک API-ها میتوانید درخواست خود را به LLM ارسال کرده و پاسخ متناظر با آن را دریافت کنید. بدینترتیب میتوانید از امکانات این مدلهای قدرتمند در برنامههای خود بهره ببرید.

API مربوط به OpenAI

بهوسیله API فراهم شده توسط OpenAI میتوانید از مدلهای قدرتمند این شرکت مانند GPT-4 در برنامههای خود بهرهمند شوید. انتخاب مدل مناسب ممکن است با توجه به نیازها، شرایط پروژه و میزان بودجه شما صورت گیرد و برای انجام کارهایی مانند تولید محتوای متنی، خلاصهسازی، ترجمه و غیره میتوانید از آنها استفاده کنید. این API مستندات واضحی دارد، استفاده از آن آسان است و امکانات گوناگونی را در اختیارتان قرار میدهد.

- لینک دسترسی به API سایت Open AI: «+»

LiteLLM

با استفاده از این کتابخانه کمحجم و رابط ساده آن میتوانید به شکل راحتتری به مدلهای زبانی گوناگون از جمله مدلهایی که توسط OpenAI، آنتروپیک، Cohere و غیره عرضه شدهاند، دسترسی داشته باشید. مزیت بزرگ «LiteLLM» این است که با ارائه رابطی واحد، تجربه استفاده از مدلهای گوناگون را بدون اعمال تغییرات عمده در کدهای پروژه فراهم میآورد.

- لینک دسترسی بهLiteLLM: «+»

Groq

هدف Groq این است که LLM-ها و بهطور کلی مدلهای هوش مصنوعی، سریع و با تأخیر پایینی اجرا شوند. برای این منظور نیز راهکاریهای نرمافزاری و سختافزاری گوناگونی را برای کاربران فراهم میکند. این پلتفرم برای برنامههای بیدرنگ همچون چتباتها و سیستمهای توصیهگر که سریع بودن آنها بسیار مهم است، انتخاب مناسبی محسوب میشود.

- لینک دسترسی Groq: «+»

Hugging Face Inference API

با استفاده از این API که توسط هاگینگفیس عرضه شده، به مدلهای متعدد و گوناگونی در زمینه پردازش زبان طبیعی، بینایی ماشین و همچنین مدلهای مربوط به صوت دسترسی خواهید داشت که از قبل، روی دادههای مرتبط آموزش دیدهاند.

از خصوصیات این API میتوان به سادگی و نحوه قیمتگذاری آن اشاره کرد. یعنی، تنها به میزان استفاده از این ابزار هزینه پرداخت میکنید. در نتیجه انتخاب مناسبی برای توسعه برنامههای کوچک و بزرگ محسوب میشود. این API با «چندوجهی» (Multi-Modal) بودن خود امکان کار با متن، عکس و صدا را نیز فراهم میکند.

- لینک دسترسی Hugging Face Inference: «+»

سرویس Azure OpenAI

این سرویس با هدف استفادههای شرکتی و سازمانی توسع یافته و امنیت و توسعهپذیری بالایی را به همراه دارد. بهوسیله «Azure OpenAI» میتوان به مدلهای قدرتمند OpenAI در پلتفرم ابری آژور دسترسی داشت. علاوه بر این، سازگاری Azure OpenAI با سایر سرویسهای «Azure» باعث شده تا توسعه اپلیکیشنهای هوش مصنوعی در محیط ابری راحتتر انجام شود.

- لینک دسترسی به Azure OpenAI Service: «+»

Vertex AI از پلتفرم ابری گوگل

پلتفرم «Vertex AI» جزو خدمات ابری گوگل یعنی «Google Cloud» محسوب میشود و در راستای ایجاد، راهاندازی و گسترش یا مقیاسدهی LLM-ها و بهطور کلی مدلهای هوش مصنوعی میتواند برایتان مفید باشد. در این پلتفرم علاوه بر اینکه به مدلهای از قبل آموزش دیده دسترسی خواهید داشت، امکان آموزش مدلهای سفارشی نیز با بهرهمندی از امکانات و زیرساختهای گوگل برایتان وجود دارد. Vertex AI یکی از بهترین گزینهها برای شرکتهایی است که در حال حاضر از خدمات ابری گوگل استفاده میکنند و میخواهند سیستم AI قدرتمند و یکپارچهای را ایجاد کنند.

- لینک دسترسی به Vertex AI: «+»

در این قسمت، با API-های گوناگونی آشنا شدید که هر یک، ویژگیهای خاص خود از جمله سادگی در استفاده، سرعت یا امنیت در مقیاس سازمانی را ارائه میدهند. برای انتخاب API مناسب میبایست نیازهای خاص خود همچون میزان بودجه، مقیاس برنامه و گستردگی اپلیکیشن و همچنین میزان آشنایی خود با هر یک از این پلتفرمها را مدنظر قرار دهید . بنابراین با اطلاع از این موارد میتوانید مدلهای زبانی را به شکلی بهتر و مفیدتر در برنامههای خود استفاده کنید.

خود میزبان سازی LLM ها

شما میتوانید مدلهای بزرگ زبانی را روی سرورهای شخصی خود راهاندازی کنید و با «خود میزبانسازی» (Self-Hosting) مدلها، علاوه بر کاهش هزینههای مربوطه، نظارت بیشتری نیز روی اپلیکیشنهای مبتنی بر AI داشته باشید و از بهکارگیری API-ها شخص ثالث بینیاز شوید. خود میزبانسازی LLM-ها به شما امکان میدهد تا آنها را طبق نیازهای خود تغییر داده یا به اصلاح سفارشیسازی کنید. این کار به حفظ حریم خصوصی و همچنین بهبود امنیت دادهها نیز کمک میکند.

در این قسمت برخی از بهترین ابزارهای خودمیزبانسازی LLM-ها را به شما معرفی خواهیم کرد.

OpenLLM

پلتفرم اپنسورس OpenLLM به شما کمک میکند تا بهسادگی مدلهای بزرگ زبانی را روی امکانات و زیرساخت خود راهاندازی و مدیریت کنید. شما میتوانید تنها با یک دستور، مدل خود یا مدل اپنسورسی که در نظر دارید را با ساختاری مشابه API-های OpenAI، اجرا و از قابلیتهای آن استفاده کنید. هدف OpenLLM این است که روند اضافه کردن قابلیتهای هوش مصنوعی و مجهز کردن برنامههایتان به این فناوری را ساده کند. ضمن اینکه روی فرایند راهاندازی و اجرای آن، نظارت و کنترل کاملی خواهید داشت.

- لینک گیتهاب OpenLLM: «+»

Ollama

بهعنوان یک برنامهنویس، اگر قصد راهاندازی و همچنین مدیریت مدلهای بزرگ زبانی از جمله لاما ۳، دیپسیک و غیره را دارید، فریمورک «Ollama» ابزار اپنسورس دیگری است که این کار را برایتان انجام میدهد. از خصوصیات Ollama میتوان به سازگاری بالا و کمحجم بودن آن اشاره کرد. به همین دلیل، برای برنامهنویسانی مناسب است که میخواهند LLM-های مختلف را بدون نیاز به زیر ساختهای بسیار قوی اجرا کنند.

- لینک وبسایت Ollama: «+»

vLLM

کتابخانه اپنسورس «vLLM» یکی دیگر از ابزارهای کاربردی این حوزه است که در آزمایشگاه «Sky Computing» دانشگاه برکلی ایجاد شده و طراحی آن بهشکلی بوده که مدلهای بزرگ زبانی، پاسخگویی سریعتر و بهتری داشته باشند. vLLM از مکانیزم «PagedAttention» برای بهبود بازدهی حافظه استفاده میکند. در بسیاری از کاربردهای واقعی و هنگامیکه بازدهی سیستم برایتان بسیار مهم باشد میتوانید از این ابزار بهعنوان یکی از بهترین گزینههای موجود استفاده کنید.

- لینک وبسایت vLLM: «+»

TGI

«استنتاج تولید متن» (Text Generation Inference) یا به اختصار «TGI»، مجموعه ابزاری برای راهاندازی LLM-ها و استفاده از آنها است که توسط شرکت هاگینگفیس ارائه داده شده است. این ابزار از مدلهای شناخته شدهای همچون لاما، Mistral و فالکون پشتیبانی میکند و در توسعه آن سعی شده تا استنتاج سریع و کارآمدی را ارائه دهد یا به بیان دیگر، پاسخهای بهتری را با کمترین تأخیر تولید کند. TGI، خصوصیاتی مانند امکان اجرا در مقیاسهای گوناگون و همچنین استفاده بهینه از حافظه را بههمراه دارد. بههمین دلیل، گزینه مناسبی برای مدیریت اپلیکیشنهای هوش مصنوعی در مقیاسهای بزرگ محسوب میشود.

- لینک وبسایت TGI: «+»

LocalAI

پلتفرم اپنسورس LocalAI را میتوان جایگزین مناسبی برای سرویسهای ابری هوش مصنوعی مانند OpenAI دانست. با این تفاوت که بهصورت خود میزبانسازی عمل میکند. شما میتوانید این ابزار را برای خودمیزبانی مدلهای متنوعی همچون مدلهای ساخت عکس، مبدلهای صدا به متن، مدلهای بزرگ زبانی و غیره روی زیرساخت سختافزاری خود استفاده کنید. LocalAI با هدف حفظ حریم شخصی و مدیریت بهتر دادهها، توسعه پیدا کرده است. به همین دلیل انتخابی مناسب برای شرکتهایی محسوب میشود که نمیخواهند دادههای خود را در اختیار خدمات شخص ثالث قرار دهند.

- لینک وبسایت LocalAI: «+»

ابزارهایی که در این قسمت به شما معرفی کردیم، نقاط قوت و ویژگیهای خاص خود را دارند. ضمن اینکه به لحاظ پیچیدگی و سختی در استفاده نیز با هم فرق دارند. بههمین دلیل، برای انتخاب ابزار مناسب برای خود میبایست شرایط و الزامات موجود مانند حجم دادهها، نوع مدل مدنظر و امکانات موجود را در نظر بگیرید. همچنین، باید اشاره کنیم که خودمیزبانسازی LLM-ها ممکن است سختتر و چالش برانگیز از بهکارگیری API-های مبتنی بر ابر باشد. با این وجود، انعطافپذیری بیشتری را در اختیارتان قرار میدهد.

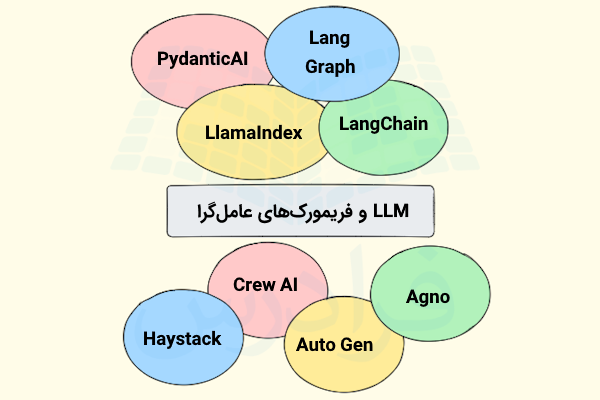

LLM و فریمورک های عامل گرا

یکی از مهمترین مراحل در توسعه اپلیکیشنهای هوش مصنوعی که از LLM یا سیستمهای عاملگرا استفاده میکند، انتخاب فریمورکهای و ابزارهای مناسب برای این کار است. این ابزارها میتوانند در موارد مختلفی مانند فهرست زیر برایتان مفید باشند.

- مدیریت دادهها

- اتصال و ارتباط با مدلهای گوناگونی هوش مصنوعی

- ایجاد عاملهای هوشمند با تونایی برقراری ارتباط و حل مسائل مختلف.

در این قسمت میخواهیم برخی از فریمورکهای مورد استفاده در توسعه برنامههای مبتنی بر LLM و همچنین اپلیکیشنهای عاملگرای هوش مصنوعی را معرفی کنیم.

LangChain

نخستین ابزاری که در اینجا معرفی میکنیم، «LangChain» نام دارد. فریمورک اپنسورسی که به کمک آن میتوانید بهراحتی اپلیکیشنهای AI خود با مدلهای بزرگ زبانی توسعه دهید. بهکمک این ابزار میتوانید LLM-ها را به وبسایتها، پایگاههای داده و سایر منابع دادهای خارجی متصل کنید تا عملکرد بهتری را در کاربردهای واقعی ارائه دهند. با استفاده از LangChain همچنین میتوانید فرایندهای گوناگون هوش مصنوعی مانند پرسیدن سوال و خلاصهسازی اطلاعات را با هم ترکیب کرده و بهصورت زنجیرهوار انجام دهید.

- لینک وبسایت LangChain: «+»

LlamaIndex

«لاما ایندکس»، به برنامهنویسان امکان میدهد تا مدلهای بزرگ زبانی را به منابع دادهای مدنظر خود همچون فایلهای «PDF»، پایگاههای دادهای «SQL» و API-ها متصل کرده تا از اینگونه دادهها نیز برای تولید پاسخ استفاده شود. این ابزار اپنسورس همچنین کمک میکند تا عمل بازیابی و ایندکسگذاری بهراحتی انجام شود تا از این طریق بتوانیم اپلیکیشنهایی را توسعه دهیم که بر مبنای دادههای مشخص و مدنظر ما، درخواستها را فهمیده و پاسخهای مناسبی را تولید کنند. ابزار «LlamaIndex» علاوه بر ویژگيهای اشاره شده، از ساز و کار RAG هم پشتیبانی میکند که بهوسیله آن میتوان پاسخهای دقیقتر و بهتری را از هوش مصنوعی دریافت کرد. به دلیل اینکه اطلاعات موجود در منابع بیرونی نیز در تولید پاسخ مورد استفاده قرار میگیرند.

- لینک وبسایت LlamaIndex: «+»

PydanticAI

کتابخانه «Pydantic»، یکی از ابزارهای پایتون است که بهوسیله آن میتوان دادهها را اعتبارسنجی کرد. عرضه کننده این کتابخانه، ابزار جدیدتری به نام «PydanticAI» را عرضه کرده است که برنامهنویسان را در توسعه برنامههای مبتنی بر هوش مصنوعی مولد یاری میدهد. ضمن اینکه در این فرایند به صحتسنجی دادهها نیز توجه خاصی دارد. با بهرهمندی از این ابزار، به مدلهای گوناگونی نظیر آنتروپیک و OpenAI دسترسی خواهید داشت. همچنین، از ویژگی «صحتسنجی نوع» کتابخانه Pydantic استفاده میشود تا دادههای معتبر و ساختارمندی را داشته باشیم. در نتیجه، با کاهش خطاها، برنامه پایدارتری خواهیم داشت.

- لینک وبسایت PydanticAI: «+»

AutoGen

ابزار دیگری که در این قسمت معرفی میکنیم، «AutoGen» نام دارد. به کمک این فریمورک اپنسورس میتوانید برنامههایی را توسعه دهید که از چندین عامل هوش مصنوعی استفاده میکنند. بدینترتیب، امکان توسعه اپلیکیشنهای پیشرفته هوش مصنوعی نیز فراهم خواهد شد. چون این عاملها در تعامل با یکدیگر میتوانند برای حل مسائل پیچیده راهکاری پیدا کنند. AutoGen که توسط مؤسسه مایکروسافت ریسرچ معرفی شده، این امکان را نیز مهیا کرده تا با کمترین دانش کدنویسی هم بتوانید برنامههای مبتنی بر AI خود را بسازید و آنها را ارزیابی کنید.

- لینک وبسایت AutoGen: «+»

Agno

گاهی اوقات نیاز میشود تا اپلیکیشنهایی را توسعه دهید که عملکردی قابل فهم و واضح داشته باشند. این موضوع در حوزههای حساس مانند امور مالی و بهداشت و درمان اهمیت زیادی دارد. فریمورک اپن سورس «Agno» یکی از ابزارهایی است که امکان ساخت عاملهای هوش مصنوعی را بهنحوی فراهم میکند که تصمیمها و اینکه چه کاری انجام میدهند را بهشکلی قابل درک بیان کنند. شما همچنین میتوانید از این فریمورک برای ساخت عاملهایی استفاده کنید که تواناییها و وظایف مشخصی دارند.

- لینک وبسایت Agno: «+»

CrewAI

این فریمورک اپنسورس، امکان ایجاد و همچنین مدیریت مجموعهای از عاملهای هوشمند را در قالب تیم یا مجموعهای از عاملها، برای برنامهنویس فراهم میکند. درست مانند گروهها و تیمهایی که ما انسانها با اهداف مشخص تشکیل میدهیم، این عاملهای هوشمند نیز با همکاری هم سعی دارند تا برای مسائل پیچیده راهکاری مناسب پیدا کنند.

CrewAI همچنین امکان ایجاد یک عامل AI با نقش یا وظیفهای مشخص هم فراهم میکند که ممکن است ابزارهای مخصوص به خود را داشته باشد و در راستای رسیدن به هدف مشخص تلاش کند. بهطور مثال میتوانید عاملهایی ایجاد کنید که نقش نویسنده یا پژوهشگر را بر عهده دارند.

- لینک وبسایت CrewAI: «+»

Haystack

برای توسعه برنامههای هوش مصنوعی مجهز به «تولید تقویت شده با بازیابی» یا RAG میتوانید از پلتفرم اپنسورس «Haystack» استفاده کنید. بدینترتیب، برنامههای هوش مصنوعی برای اینکه بتوانند پاسخهایی بهتر و صحیحتر را برای درخواستهای کاربر ایجاد کنند، اسناد و اطلاعات را از منابع بیرونی پیدا کرده و بازیابی میکنند. این فریمورک برای ساخت برنامههایی مانند چتباتها و سیستمهای «پرسش و پاسخ» که به پردازش حجم بالایی از دادهها و اطلاعات نیاز دارند میتواند بسیار کاربردی و سودمند باشد.

- لینک وبسایت Haystack: «+»

LangGraph

فریمورک «لَنگگراف»، ابزار اپنسورسی است که بر مبنای «LangChain» ایجاد شده است و به شما امکان میدهد تا سیستمها و جریانهای کاری چند عاملی بسازید. در اینگونه سیستمها، عاملهای هوش مصنوعی میتوانند با هم تعامل داشته باشند و بهشکلی هماهنگ و بدون مشکل با هم کار کنند. بنابراین، اگر قصد توسعه سیستمهای پیشرفته و پیچیده هوش مصنوعی را دارید، استفاده از LangGraph میتواند برایتان مفید باشد. این ابزار کمک میکند تا عناصر سیستم بهشکلی مناسب و هماهنگ با هم کار کنند.

- لینک وبسایت LangGraph: «+»

فریمورکها و ابزارهایی که در این قسمت به شما معرفی کردیم، هر یک نقاط قوت و خصوصیات مخصوص به خود را دارند. بههمین دلیل میتوان از آنها برای ساخت انواع اپلیکیشنهای هوش مصنوعی استفاده کرد. اینکه کدام ابزار یا فریمورک برای کار شما مناسب است به شرایط و نیازهای شما و موارد مختلفی مانند منبع دادهها، میزان سختی و پیچیدگی فرایندها، میزان شفافیت مورد نیاز و غیره بستگی دارد. با شناسایی و درک این موارد میتوانید اپلیکیشنهای AI قدرتمند و اثربخشی را توسعه دهید.

آشنایی با برخی مفاهیم هوش مصنوعی

اگر به دانستن طرز کار سیستمهای AI و مدلهای بزرگ زبانی علاقهمند هستید، پیش از هر چیز لازم است با مفاهیم مهم و پایهای این حوزه آشنا شوید. این اطلاعات به شما کمک میکنند تا از عملکرد پشتصحنه اینگونه سیستمها مطلع شوید و بهشکل بهتری از هوش مصنوعی استفاده کنید. در این قسمت میخواهیم برخی از مهمترین مفاهیم این حوزه را برایتان شرح دهیم.

توکن سازی

LLM برای فهمیدن و پردازش متنها، آنها را به بخشهای کوچکتری مانند کلمات یا عناصری کوچکتر تجزیه میکند که به هر یک از این مؤلفهها یک توکن گفته میشود. این فرایند، یکی از مهمترین مراحل در آمادهسازی متن برای پردازش توسط مدلهای هوش مصنوعی محسوب میشود و انجام صحیح آن به مدلها کمک میکند تا زبانهای گوناگون و واژگان مختلف را بهشکلی مؤثر پردازش کنند.

امبدینگ

«بردارسازی» (Embeddings) یا امبدینگ فرایندی است که طی آن عبارات و کلمات به وکتور یا بردارهای عددی تبدیل میشوند. این بردارها معانی و ارتباط بین این کلمات را نگه میدارند و وجود آنها به مدلهای هوش مصنوعی کمک میکند تا علاوه بر فهمیدن راحتتر زبان ما انسانها، آن را بدون دردسر پردازش کنند. مدلهای بزرگ زبانی بهوسیله بردارسازی و وکتورهایی که از کلمات ساخته شده، شباهت بین کلمات را به لحاظ معنا نیز پیدا میکنند.

معماری ترنسفورمر

این معماری نخستین بار در سال ۲۰۱۷ در مقالهای با عنوان «Attention Is All You Need» معرفی شد و بیشتر LLM-های کنونی بر مبنای اصول این معماری ساخته میشوند. در این معماری، با تکنیکی به نام «توجه به خود» (Self-Attention) رو به رو هستیم که در آن بهجای پردازش یک به یک کلمات موجود در جمله، تمامی آنها به یکباره پردازش میشوند. بدینترتیب، مدلهای بزرگ زبانی، «زمینه» (Context) کلمات را بهتر و دقیقتر میفهمند و در انجام کارهایی همچون خلاصهسازی، ترجمه و تولید متن عملکرد بهتری خواهند داشت.

تولید تقویت شده با بازیابی یا RAG

«تولید تقویت شده با بازیابی» (Retrieval-Augmented Generation | RAG)، ساز و کاری است که نقاط قوت هر دو نوع «سیستمهای مبتنی بر بازیابی» و همچنین «مدلهای مولد» را تلفیق کرده و به ما ارائه میدهد. این روش برای مواقعی که انتظار دریافت اطلاعاتی معتبر، واقعی یا بهروز از سیستم هوش مصنوعی داریم بسیار مفید و کاربردی است. ساز و کار RAG به این شکل است که مدل در گام نخست اطلاعات مرتبط با پرامپت را از منبعی مانند مجموعه اسناد یا پایگاه داده بازیابی میکند. سپس پاسخ دقیق و صحیحتری را بر اساس این اطلاعات تولید میکند.

در یکی از مطالب پیشین مجله فرادرس گفتیم که RAG چیست و طرز کار، کاربردها و پیادهسازی آن را نیز شرح دادیم که مطالعه آن میتواند برایتان مفید باشد.

یادگیری انتقال

مدلهای هوش مصنوعی با استفاده از روش «یادگیری انتقال» (Transfer Learning) میتوانند از اطلاعات و دانشی که برای انجام یک کار مشخص به دست آوردهاند، در کار مرتبط دیگر نیز استفاده کنند. بدینترتیب، با توجه به اینکه مدلهای جدید را مجدد و از ابتدا برای کارهای مورد نظر آموزش نمیدهیم، تا حد زیادی در صرف زمان و منابع صرفهجویی خواهد شد.

تنظیم دقیق

فرض کنید مدلی داریم که پیش از این برای انجام کار مشخصی آموزش دیده است و اکنون میخواهیم آن را به مدلی تبدیل کنیم که برای انجام کارهای تخصصی مدنظرمان نیز عملکرد دقیقی داشته باشد. برای این منظور، مدل را با دیتاستی کوچکتر و تخصصی آموزش میدهیم. به این تغییر مختصر که روی مدلها انجام میشود «تنظیم دقیق» (Fine-Tuning) گفته میشود و مزیت آن این است که بدون نیاز به حجم زیادی از دادههای جدید میتوانیم، مدلهای تخصصی و دقیقتری را توسعه دهیم.

یادگیری بدون نمونه

هنگامیکه یک مدل هوش مصنوعی بتواند کارهای خاصی را انجام دهد که از قبل بهطور دقیق برای آن کار آموزش ندیده است، با «یادگیری بدون نمونه» (Zero-Shot Learning) رو به رو هستیم. به بیان دیگر میتوان گفت که مدل هوش مصنوعی در چنین مواقعی از دانش کلی خود، برای پاسخگویی و پیشبینیهای مرتبط با کارهای جدید استفاده میکند. برای درک بهتر، چتباتی را در نظر بگیرید که میتواند به پرسشهای تخصصی شما در زمینهای خاص پاسخ دهد. با اینکه بهطور مستقیم روی دادههای آن حوزه آموزش ندیده است.

یادگیری تک نمونه ای

گاهی اوقات ممکن است فرایند جمعآوری مقدار زیادی داده برای آموزش مدل سخت بوده یا اینکه هزینه زیادی را به دنبال داشته باشد. در چنین مواقعی بهکارگیری تکنیکی به نام «یادگیری تکنمونهای» (One-Shot Learning) میتواند بسیار مفید باشد. در روش یادگیری تکنمونهای، مدل یاد میگیرد که با دیدن تنها یک نمونه، بتواند موارد جدید را شناسایی کرده یا دستهبندی کند. چنین مدلی برای آنکه بتواند پیشبینیهای دقیقی را با کمترین نمونههای یادگیری انجام دهد، از دانش پیشین خود بهشکلی صحیح و مؤثر استفاده میکند.

یادگیری با داده های محدود

در مواقعی که نمیتوان بهسادگی حجم زیادی از دادههای برچسبدار را برای انجام کارهایی مانند تحلیل احساسات و ترجمه زبانها آماده کرد، از شیوهای به نام «یادگیری با تعداد کمی نمونه» (Few-Shot Learning) استفاده میشود. فرق این روش با یادگیری تکنمونهای این است که بهجای آموزش دیدن با یک نمونه، مدل با چندین نمونه آموزش میبیند و سعی میکند علیرغم دادههای بسیار محدود، عملکرد خوبی را ارائه دهد.

آشنایی با مفاهیم معرفی شده در این قسمت به شما کمک میکند تا درک بهتری از طرز کار مدلهای بزرگ زبانی و همچنین، نحوه استفاده صحیح از آنها در پروژههای خود پیدا کنید. علاوه بر این، اطلاع از اتفاقات پشت صحنه اینگونه سیستمها شما را در گرفتن تصمیمهای بهتر به هنگام ساخت برنامههای مبتنی بر هوش مصنوعی یاری میدهد.

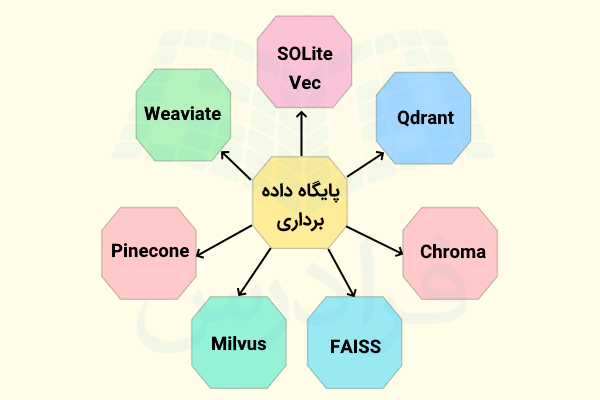

پایگاه های داده برداری

پایگاههای داده برنامههایی هستند که میتوانند دادهها را به شیوهای مناسب و بهینه ذخیره و مدیریت کنند. بههمین دلیل، یکی از مهمترین قسمتهای اپلیکیشنها محسوب میشوند. در حال حاضر به انواع مختلفی از پایگاه دادهها دسترسی داریم که از موارد شناخته شده آن میتوان به پایگاه دادههای رابطهای و SQL اشاره کرد. همچنین، پایگاه دادههای گراف و NoSQL را نیز داریم که میتوانند انواع مختلفی از دادهها را به شیوهای بهتر مدیریت و پردازش کنند.

پایگاههای داده برداری در اپلیکیشنهای هوش مصنوعی جایگاه بسیار مهمی دارند، بهویژه اپلیکیشنهایی که از تکنیک RAG بهره میبرند. این نوع دیتابیسها دادهها را در قالب بردارهایی در ابعاد بزرگ نگه میدارند. به همین دلیل پیدا کردن و بازیابی اطلاعات مشابه راحتتر خواهد بود. در این قسمت میخواهیم برخی از محبوبترین موتورهای جست و جو و پایگاههای داده برداری را به شما معرفی کنیم.

SQLite-Vec

«SQLite»، پایگاه دادهای کمحجم و محبوب است. این پایگاه داده رابطهای، افزونهای به نام «SQLite-Vec» دارد که بهوسیله آن میتوانید امبدینگهای برداری را از طریق SQLite مدیریت و پردازش کنید. در نتیجه، بدون نیاز به پایگاه داده برداری جداگانه، جست و جوهای برداری خود را بهسادگی انجام دهید. همین ویژگیها، SQLite-Vec را به گزینهای مناسب برای استفاده در پروژههای کوچک و متوسط هوش مصنوعی تبدیل کرده است.

- لینک دسترسی به SQLite-Vec در گیتهاب: «+»

Chroma

«Chroma» نوعی پایگاه داده برداری است که برای توسعه اپلیکیشنهای هوش مصنوعی میتوانید از آن استفاده کنید. از خصوصیات این پایگاه داده میتوان به قابلیت پردازش دادههای گوناگون مانند عکس و متن اشاره کرد. ضمن اینکه جست و جوی شباهت را نیز میتواند با سرعت بالایی انجام دهد. این ابزار اپنسورس برای اپلیکیشنهایی که لازم است جست و جو در آنها بهطور دقیق و با سرعت زیادی انجام شود گزینهمناسبی است.

- لینک دسترسی به وبسایت Chroma: «+»

Qdrant

موتور جست و جوی برداری «Qdrant»، یکی از گزینههایی است که در توسعه اپلیکیشنهای بزرگمقیاس و پیشرفته میتوان به آن تکیه کرد و عملکرد و سرعت خوبی را در این رابطه ارائه میدهد. این ابزار اپنسورس و ابری علاوه بر فیلتر کردن، امکان جست و جوی ترکیبی شامل تکنیکهای سنتی و همچنین روشهای مبتنی بر بردار را نیز ارائه میدهد.

- لینک دسترسی به وبسایت Qdrant: «+»

Pinecone

سرویس «Pinecone» در واقع یک پایگاه داده برداری محسوب میشود که به کمک آن میتوانید امبدینگهای برداری را بهراحتی ذخیره، جست و جو و ایندکسگذاری کنید. این ابزار برای کاربردهای واقعی طراحی شده و نیازی به تنظیمات و مدیریت دستی ندارد. مقیاسپذیری و ایندکسگذاری بیدرنگ جزو خصوصیات این پایگاه داده محسوب میشوند.

بهطور کلی، میتوان این ابزار را راهکاری مطمئن برای مدیریت دادههای برداری دانست که میتوانید بدون نیاز به تنظیمات دستی از آن استفاده کنید.

- لینک دسترسی به وبسایت Pinecone: «+»

Weaviate

این ابزار در واقع یک موتور جست و جو محسوب میشود که علاوه بر جست و جوی برداری، امکان مدیریت دادههای ساختارمند را نیز ارائه میدهد. «Weaviate» همچنین برای اینکه بتواند خروجیهای دقیقتری را ارائه دهد جست و جوی ترکیبی یا هیبرید را با تلفیق جست و جوی برداری و همچنین جست و جوی مبتنی بر متا دیتا انجام میدهد.

از خصوصیات این ابزار میتوان به ماژولهای داخلی برای پردازش زبان طبیعی و مقیاسپذیری بسیار بالای آن اشاره کرد که Weaviate را به انتخابی عالی برای اپلیکیشنهای بزرگمقیاس هوش مصنوعی و همچنین پروژههای کوچکتر تبدیل میکند.

- لینک دسترسی به وبسایت Weaviate: «+»

FAISS

کتابخانه «FAISS»، ابزاری قدرتمندی است که توسط هوش مصنوعی فیسبوک معرفی شده و برای پیدا کردن سریع شباهتها و همچنین خوشهبندی «بردارهای متراکم» مورد استفاده قرار میگیرد. در برخی از کاربردها از جمله مواردی که در ادامه فهرست شده، نیاز داریم تا مجموعهای از بردارها را خیلی سریع با هم مقایسه کنیم و میزان شباهت آنها را بسنجیم.

- جست و جوی تصاویر

- سیستمهای توصیهگر

در اینگونه مواقع میتوان از ابزار اپنسورس FAISS کمک گرفت.

از دیگر خصوصیات این کتابخانه میتوان به امکان بهرهمندی از قدرت پردازنده گرافیکی یا GPU در انجام کارها اشاره کرد و سرعت بخشیدن به پردازشها اشاره کرد. که برای کار با دیتاستهای حجیم و پردازش آن میتواند بسیار مفید باشد.

- لینک دسترسی به FAISS در گیتهاب: «+»

Milvus

پایگاه داده «Milvus»، ابزاری است که میتوان از قابلیتهای آن برای مدیریت و جست وجوی سریع و مؤثر در دیتاستهای بسیار بزرگ و حجیم بهرهمند شد. از خصوصیات این پایگاه داده برداری، میتوان به مقیاسپذیری بالا و همچنین امکان استفاده از انواع گوناگون ایندکسها اشاره کرد که سرعت جست و جو را افزایش میدهند. مقیاسپذیر بودن این ابزار امکان استفاده از آن برای برنامههای بسیار بزرگ و گسترده را مهیا میکند. Milvus همچنین، به عنوان ابزاری اپنسورس، یکپارچگی مناسبی با فریمورکها و ابزارهای حوزه یادگیری ماشین دارد. از کاربردهای این پایگاه داده نیز میتوان به موارد زیر اشاره کرد.

- سیستمهای توصیهگر

- بازیابی تصاویر

- وظایف مربوط به پردازش زبان طبیعی

- لینک دسترسی به وبسایت Milvus: «+»

در این قسمت با برخی از مهمترین پایگاه دادههای برداری آشنا شدید. برای اینکه بتوانید بهترین مورد را برای اپلیکیشن هوش مصنوعی خود انتخاب کنید، لازم است موارد زیر را در نظر بگیرید.

- گستردگی و مقیاس اپلیکیشن

- بودجه در نظر گرفته شده برای توسعه اپلیکیشن

- دقت و سرعت مورد انتظار برای دریافت خروجی

اطلاع از این موارد به شما کمک میکند تا دادههای خود را به شکل بهتری ذخیره و جست و جو کنید و با انجام این کار، اپلیکیشن پایدارتر و سریعتری داشته باشید.

مدیریت و اعتبارسنجی داده ها

یکی از مواردی که بههنگام توسعه اپلیکیشنهای هوش مصنوعی میبایست به آن توجه داشته باشید، استاندارد بودن قالب دادهها است. این مورد باعث میشود تا دادهها بهشکلی صحیح توسط قسمتهای مختلف برنامه تفسیر و بهکار برده شوند. علاوه بر این، هنگامیکه دادهها قالبی استاندارد و یکسان داشته باشند، نقل و انتقال آنها بین برنامهها یا ماژولهای مختلف اپلیکیشن آسانتر و بدون بروز مشکل صورت میگیرد.

همانطور که پیشتر نیز اشاره کردیم، برای تعریف و بررسی ساختارها و مدلهای داده در پایتون کتابخانه «Pydantic» را داریم که ابزار رایجی برای این کار محسوب میشود. علاوه بر این، قالب محبوب و پراستفاده JSON را داریم که فرمت پرکاربردی برای تبادل و انتقال دادهها بین وباپلیکیشنها بهشمار میرود. در این قسمت میخواهیم تعدادی از مهمترین ابزارهای مدیریت و اعتبارسنجی دادهها را به شما معرفی کنیم.

Pydantic

زبان برنامهنویسی پایتون، کتابخانهای به نام «Pydantic» دارد که بهکمک آن میتوان کارهایی مانند تعریف مدلهای دادهای با استفاده از «راهنمای نوع» (Type Hints) و همچنین اعتبارسنجی خودکار دادهها را انجام دهید. این ابزار پیش از بهکار بردن دادهها در برنامه، سازگاری آنها با قالب مدنظر را بررسی میکند. با این کار از بروز خطاها پیشگیری شده و پایداری کدهای برنامه نیز بیشتر میشود. از خصوصیات این کتابخانه میتوان به سادگی و سرعت بالای آن اشاره کرد. به همین دلیل آن را بهشکل گستردهای در برنامههای هوش مصنوعی مبتنی بر پایتون بهکار میگیرند. علاوه بر موارد اشاره شده، Pydantic سازگاری خوبی با فریمورک محبوب ساخت API در پایتون یعنی «FastAPI» دارد.

ویژگی های Pydantic

در ادامه برخی با برخی از ویژگیهای این کتابخانه اعتبارسنجی آشنا خواهید شد.

- الزم به تعیین نوع: کتابخانه Pydantic با بررسی انطباق دادههای برنامه با نوع مشخص شده توسط کاربر میتواند خطاهای زمان اجرا را کاهش دهد.

- مدلهای تو در تو: این کتابخانه امکان ایجاد مدلهای «تو در تو» و ساختارهای دادهای پیچیده را نیز فراهم میکند.

- استفاده آسان: این کتابخانه، سینتکس سادهای دارد و کدنویسی با آن آسان است. به همین دلیل بهراحتی میتوانید ساختارهای دادهای را تعریف و اعتبارسنجی کنید.

بهطور کلی، کتابخانه Pydantic نقش مهم و ارزشمندی در برنامههای هوش مصنوعی و پردازش منسجم و صحیح دادهها دارد. این ابزار میتواند از بروز خطاهای غیرقابل پیشبینی پیشگیری کند و پایداری برنامهها را افزایش دهد. چون دادهها را پیش از استفاده اعتبارسنجی میکند.

JSON

«نشانهگذاری شی جاوا اسکریپت» (JavaScript Object Notation) یا به اختصار JSON، فرمت یا قالب متنی سادهای است که برای انتقال دادهها، بهطور مثال برای تبادل دادهها بین سرور و کلاینت در محیط وب و وباپلیکیشنها، مورد استفاده قرار میگیرد. سادگی این قالب باعث شده تا خواندن، نوشتن و بهطور کلی استفاده از آن برای کامپیوترها و همچنین انسانها پیچیدگی خاصی نداشته باشد. ساختار JOSN بسیار ساده است و بهصورت زوجهای «کلید-مقدار» نوشته میشود. بههمین دلیل میتوان از آن برای انتقال دادههای ساختارمند بین قسمتهای مختلف برنامههای هوش مصنوعی، مانند API-ها، پایگاههای داده، مدلهای یادگیری ماشین و غیره استفاده کرد.

فیلم آموزش رایگان روشهای خواندن فایل JSON بههمراه مثال جیسون در زبانهای برنامهنویسی از فرادرس که لینک آن نیز در ادامه آورده شده، اطلاعات عملی و مفیدی را در این باره در اختیارتان قرار میدهد.

ویژگی های JSON

در ادامه برخی از خصوصیات JSON را آوردهایم.

- سادگی: فهمیدن کدهای JSON و همچنین نوشتن دادهها در این فرمت بسیار ساده است. به این دلیل که JSON، سینتکس سادهای دارد.

- سازگاری: روش شناخته شدهای برای انتقال دادهها محسوب میشود. همچنین به دلیل پشتیبانی بیشتر زبانهای برنامهنویسی از آن، روش عمومی برای این کار محسوب میشود.

- سبک بودن:اگر بخواهیم JSON را با سایر فرمتهای داده مانند «XML» مقایسه کنیم، باید بگوییم که استفاده از آن راحتتر است و فضای کمتری را اشغال میکند، به همین دلیل پهنای باند مصرفی در وباپلیکیشنها را کاهش میدهد.

آشنایی با JSON و بلد بودن طرز کار آن برای برنامهنویسانی که به توسعه برنامههای مبتنی بر هوش مصنوعی علاقه دارند، بسیار مفید و ارزشمند است. چون این فرمت دادهای دراپلیکیشنهای هوش مصنوعی برای تبادل دادهها با API یا ذخیره تنظمیات و پارامترهای مدل مورد استفاده قرار میگیرد.

در این قسمت به موضوع مدیریت و اعتبارسنجی دادهها پرداختیم و با ابزارهایی مانند JSON و کتابخانه Pydantic برای این منظور آشنا شدیم. داشتن مهارت کار با این ابزارها به شما کمک میکند تا فرایند توسعه، تست و نگهداری برنامههای قابل اعتماد و بهینه هوش مصنوعی را راحتتر انجام دهید. استفاده از این ابزارها به منظور مدیریت دادهها و بررسی صحت آنها، از بروز خطاهایی با منشأ فرمتهای ناسازگار پیشگیری میکند و باعث میشود تا اجرای صحیح و بیدردسر برنامههای هوش مصنوعی را شاهد باشیم.

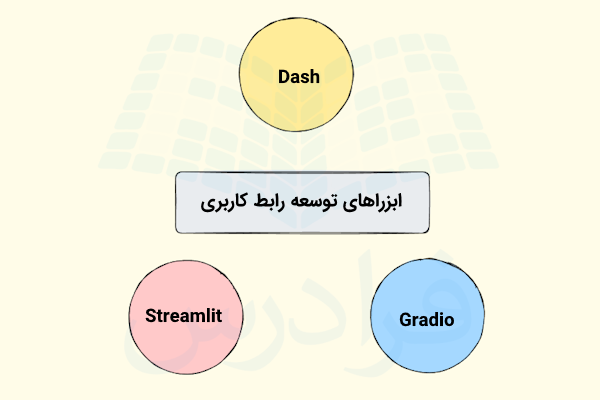

ابزارهای توسعه رابط کاربری

برای طراحی و ساخت رابط کاربری برای اپلیکیشنهای هوش مصنوعی میتوانید از زبانها و فناوریهای زیر استفاده کنید.

- HTML

- CSS

- جاوا اسکریپت

همچنین اگر تجربه قبلی در طراحی وب و موارد اشاره شده ندارید، باز هم جای نگرانی نیست. چون ابزارهایی وجود دارند که به کمک آنها میتوانید UI برنامههای خود را خیلی سریع، راحت و بدون نیاز به حجم زیادی از کدنویسی ایجاد کنید. مهمترین مزیت استفاده از این ابزارها این است که میتوانید بیشتر توجه و تمرکز خود را به توسعه قابلیتهای هوش مصنوعی اپلیکیشن اختصاص دهید. ضمن اینکه برنامهتان دارای رابط کاربری و همچنین تجربه کاربری جذاب و مناسبی خواهد بود. در این قسمت میخواهیم برخی از بهترین ابزارهای توسعه رابط کاربری برای اپلیکیشنهای هوش مصنوعی را به شما معرفی کنیم.

Streamlit

نخستین ابزاری که در اینجا معرفی میکنیم، «Streamlit» نام دارد. این کتابخانه اپنسورس پایتونی، فرایند توسعه وباپلیکیشنهای جذاب و تعاملی برای برنامههای علم داده و هوش مصنوعی را برایتان ساده میسازد. حتی اگر HTML یا جاوا اسکریپت هم بلد نباشید، باز هم به کمک این ابزار میتوانید مصورسازی دادهها و داشبوردهای مخصوص به خود را با اسکریپتهای ساده پایتونی توسعه داده و در اختیار سایر افراد قرار دهید. این ابزار برای ایجاد پروتوتایپ از مدلها نیز میتواند برایتان مفید باشد.

- لینک وبسایت Streamlit: «+»

Gradio

کتابخانه اپنسورس دیگری که میتوانید برای توسعه رابط کاربری برای مدلهای یادگیری ماشین خود از آن استفاده کنید «Gradio» نام دارد. از قابلیتهای این ابزار در راستای تسهیل تعامل کاربر با مدلهای AI میتوان به امکان افزودن کامپوننتهای ورودی و خروجی سفارشی مانند فیلدهای ورودی متنی، نوارهای لغزنده، دکمههای آپلود تصویر و غیره اشاره کرد. یکی از کاربردهای ارزشمند این کتابخانه، بررسی و ارزیابی مدلها است. چون میتوانید ورودیهای متفاوتی را به آن ارائه دهید و نتیجه را بلافاصله مشاهده کنید.

- لینک وبسایت Gradio: «+»

Dash

ابزار بعدی که در اینجا با آن آشنا میشوید «Dash» نام دارد. این فریمورک اپنسورس توسط شرکت «Plotly» عرضه شده و امکان توسعه وباپلیکیشنهای تحلیل داده با پایتون را در اختیار شما قرار میدهد. در صورتیکه قصد توسعه اپلیکیشنهای پیشرفته و سازمانی را داشته باشید، Dash میتواند یکی از بهترین گزینههای موجود باشد که قابلیتها و انعطافپذیری بیشتری را نسبت به ابزارهای Streamlit و Gradio در اختیارتان قرار میدهد. با استفاده از امکانات این ابزار میتوانید داشبوردهایی شامل نمودارها و گرافهای تعاملی ایجاد کنید که در زمینه بررسی کارایی مدلهای هوش مصنوعی و نظارت بر آنها بسیار مفید خواهند بود.

- لینک وبسایت Dash: «+»

در این قسمت مجموعهای از ابزارها را به شما معرفی کردیم که در ساخت رابط کاربری برای برنامههای هوش مصنوعی میتوانند مفید باشند. حال اگر این سوال برای شما پیش آمده که کدام ابزار را میبایست در پروژه خود استفاده کنید، باید بگوییم که این مورد به ویژگیهای پروژه و نیازهای شما بستگی دارد. بهطور مثال، اگر به دنبال ابزاری هستید که بهسادگی و با سرعت بالا این کار را برایتان انجام دهد، Streamlit یا Gradio میتوانند انتخاب خوبی باشند. همچنین، ابزار Dash بهدلیل انعطافپذیری و قابلیتهای خود، برای اپلیکیشنهای پیشرفتهتر مناسبتر است. آشنایی با این ابزارها و خصوصیات هریک به شما کمک میکند تا رابطهای کاربری جذاب و کاربرپسندی را برای اپلیکیشنهای خود بسازید و کاربران راحتتر از آنها استفاده کنند.

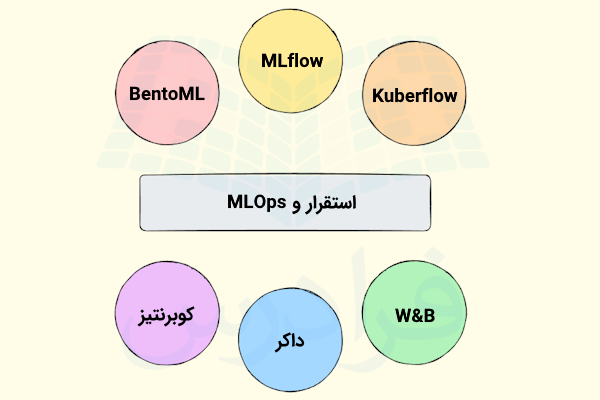

استقرار و MLOps

یکی از مهمترین کارهایی که پس از توسعه اپلیکیشن هوش مصنوعی یا LLM میبایست انجام دهید، راهاندازی آن است تا سایر کاربران نیز بتوانند از مزایای آن بهرهمند شوند. این مرحله که با نام «راهاندازی | استقرار» (Deployment) نیز شناخته میشود میتواند وظایفی مانند نصب اپلیکیشن ساخته شده روی سرور، مدیریت و انجام بهروزرسانیها و سایر موارد را در بر بگیرد. همچنین باید مطمئن شویم که برنامه ما میتواند به درخواست چندین کاربر بهطور همزمان پاسخ دهد. «عملیات یادگیری ماشین» یا به اختصار «MLOps» به روشهایی اشاره دارد که در راستای مدیریت بهتر راهاندازی و نگهداری از اپلیکیشنهای هوش مصنوعی میتوانند بسیار سودمند باشند.

آشنایی با این ابزارها میتواند شما را به توسعهدهنده AI بسیار ماهری تبدیل کند، حتی اگر وظایف مربوط به راهاندازی بهطور کامل به شما واگذار نشده باشد. در این قسمت، تعدادی از ابزارهای کاربردی موجود در حوزه استقرار و MLOps را به شما معرفی خواهیم کرد.

MLflow

پلتفرم «MLflow»، ابزاری است که برای مدیریت فرایندها و تمام گامهای ساخت و استفاده از مدلهای یادگیری ماشین بهکار میرود. با این ابزار اپنسورس همچنین میتوانید کارهایی مانند نظارت بر آزمایش مدلها، بستهبندی و تبدیل آنها بهشکلی قابل اجرا و استقرار مدلها را بهراحتی انجام دهید. MLflow گزینههای مختلفی مانند خدمات ابری و همچنین سرورهای محلی را نیز برای راهاندازی در اختیار شما قرار میدهد. شما همچنین میتوانید با ثبت نسخههای مختلفی از مدلها، آنها را به لحاظ کارایی با هم مقایسه کرده و بهترین مدل را برای استقرار انتخاب کنید.

Kubeflow

این پلتفرم اپنسورس، مجموعهای از ابزارهای مختلف را در اختیار شما قرار میدهد که بهکمک آنها میتوانید تمامی وظایف رایج از جمله آمادهسازی دادهها، آموزش دادن مدلها، راهاندازی، نظارت و مونیتورینگ و غیره را انجام دهید. به بیان دیگر، هدف «Kubeflow» این است که راهاندازی و مدیریت پروژههای یادگیری ماشین در کوبرنتیز را برایتان سادهتر کند. از مهمترین خصوصیات این ابزار میتوان به امکان افزایش راحتتر مقیاس مدلها با کوبرنتیز اشاره کرد.

BentoML

با استفاده از این فریمورک میتوانید مدلهای یادگیری ماشین را خیلی سریع در قالب یک API راهاندازی کنید. در واقع، «BentoML» به عنوان ابزاری اپنسورس به شما کمک میکند تا بهراحتی مدلهای آموزش داده شده را بهشکل سرویسی درآورید که قابل استفاده در کاربردهای واقعی و اپلیکیشنهای مختلف باشد. علاوه بر موارد اشاره شده، این ابزار با ایجاد ایمیجهای داکر برای مدلها این مزیت را نیز فراهم میکند تا بهراحتی آنها را روی ابزارها و محیطهای ابری یا سرورهای محلی راهاندازی کنید.

W&B

بهکمک ابزار «Weights & Biases» که به اختصار، «W&B» هم خوانده میشود، میتوانید کارهایی مانند مدیریت مدلها، مصورسازی نتایج و غیره را در حین فرایندهای ماشین لرنینگ انجام دهید. همچنین برای اینکه راحتتر مدلهای خود را بهبود دهید، امکان ثبت هایپرپارامترها، معیارهای کارایی و منابع سیستمی و همچنین امکان مقایسه آنها را در اختیار شما قرار میدهد. W&B بهطور معمول توسط تیمهای علم داده برای مشارکت در راستای بهبود عملکرد مدلها استفاده میشود.

داکر

پیش از آشنایی با داکر، میبایست با مفهوم کانتینرها آشنا شوید. کانتینرها، محفظههایی هستند که تمامی الزمات اجرای یک برنامه از جمله کدها، محیط اجرایی، کتابخانهها و سایر وابستگیهای آن را درون خود نگه میدارند. اکنون، داکر را میتوانید ابزاری در نظر بگیرید که اپلیکیشنهای شما، همچون مدلهای هوش مصنوعی را درون این کانتینرها بستهبندی میکند. مزیت کانتینرسازی این است که روند جابهجایی برنامه بین محیطهای گوناگون را سادهتر کرده و مشکلات و دغدغههای مربوط به ناسازگاری برنامه با سایر محیطها را از بین میبرد.

فیلم آموزش رایگان داکر جادی، مفاهیم و شروع کار با Docker از فرادرس که لینک آن نیز در ادامه آورده شده، اطلاعات مفیدی را در مورد این ابزار در اختیارتان قرار میدهد.

کوبرنتیز

«کوبرنتیز» (Kubernetes)، پلتفرمی است که توسط گوگل عرضه شده و برای هماهنگسازی و سازماندهی خودکار کانیترها مورد استفاده قرار میگیرد. این ابزار اپنسورس به توسعهدهندگان امکان میدهد تا عملیاتی مانند راهاندازی، افزایش مقیاس و مدیریت برنامههای کانتینری شده را بهطور خودکار انجام دهند. در واقع، به کمک این ابزار میتوانید دسته یا خوشهای از کانتینرها را در مقیاس بزرگ مدیریت و پردازش کنید.

فیلم آموزش مقدماتی کوبرنتیز و مدیریت کانتینرها با Kubernetes از فرادرس که لینک آن نیز در ادامه آورده شده، شما را با دنیای کوبرنتیز و مدیریت کانتینرها بهصورت کاربردی آشنا میکند.

کوبرنتیز میتواند بهشکل مؤثر و بهینهای پیادهسازیهای پیچیده را مدیریت کند، بههمین دلیل، بهشکلی متداول در استقرار مدلهای یادگیری ماشین و هوش مصنوعی مورد استفاده قرار میگیرد.

در این قسمت ابزارهایی را به شما معرفی کردیم که به کمک آنها میتوانید کنترل بهتری روی استقرار مدلهای هوش مصنوعی خود داشته باشید. بهگونهای که اینمدلها بتوانند بدون مشکل اجرا شوند و در مواقع لزوم بهسادگی قابل گسترش باشند. یادگیری این ابزارها و استفاده از آنها، حتی اگر خودتان مسئول راهاندازی و انجام کارهای مرتبط با آن نباشید هم باعث میشوند تا مهارت شما بهعنوان یک برنامهنویس هوش مصنوعی افزایش پیدا کند.

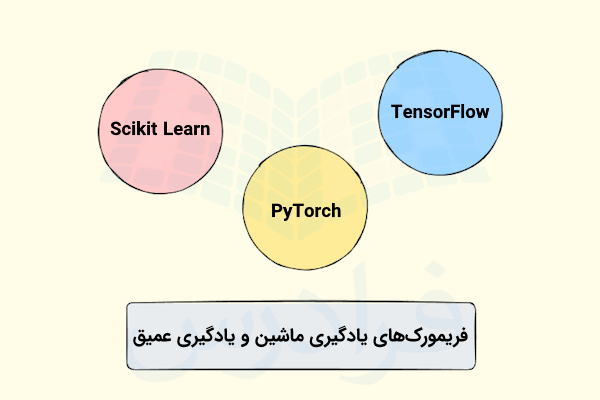

فریمورک های یادگیری ماشین و یادگیری عمیق

در برخی از پروژههای هوش مصنوعی نیاز میشود تا از سایر تکنیکها مانند الگوریتمهای یادگیری عمیق یا یادگیری ماشین نیز در کنار مدلهای بزرگ زبانی یا LLM-ها استفاده کنید. در واقع، تلفیق این موارد با هم باعث میشوند تا برنامههای AI قدرتمندتر و بهتری را توسعه دهیم. برای ایجاد و راهاندازی راحتتر چنین مدلهایی میتوانیم از فریمورکها و ابزارهای محبوب یادگیری عمیق و یادگیری ماشین استفاده کنیم. در ادامه، برخی از این فریمورکها را بررسی کردهایم.

تنسورفلو

نخستین ابزار محبوب این حوزه که معرفی میکنیم، کتابخانه تنسورفلو است. این ابزار اپنسورس که توسط گوگل توسعه داده شده به شما کمک میکند تا مدلهای یادگیری عمیق مدنظر خود را ایجاد کرده و آن را آموزش دهید. از کاربردهای این کتابخانه میتوان به برنامههایی اشاره کرد که در آنها ار شبکه عصبی استفاده میشود. تعدادی از این برنامهها را در ادامه فهرست کردهایم.

- بازشناسی و تشخیص تصاویر

- پردازش زبان طبیعی

- تشخیص گفتار

شما میتوانید با استفاده از فریمورک تنسورفلو و مجموعه ابزارها و API-هایی که در اختیارتان قرار میهد، برای توسعه انواع مدلهای هوش مصنوعی، از مدلهای ساده یادگیری ماشین گرفته تا معماریهای پیشرفته یادگیری عمیق استفاده کنید. داشتن خصوصیاتی همچون انعطافپذیری و سازگاری با شرایط گوناگون در کنار حمایت قوی از سوی جامعه برنامهنویسان باعث شده تا این فریمورک به انتخاب بسیاری از افراد و برنامهنویسان AI تبدیل شود.

مشاهده فیلم آموزش برنامه نویسی یادگیری عمیق با کتابخانه TensorFlow 2 از فرادرس که لینک آن نیز در ادامه آورده شده میتواند این فریمورک محبوب و قدرتمند را به شما یاد بدهد.

scikit-learn

«سایکیتلرن» (Scikit-Learn) یکی از محبوبترین کتابخانههای زبان پایتون در حوزه ماشین لرنینگ است که بهکمک آن میتوانید کارهای معمول یادگیری ماشین مانند موارد زیر را انجام دهید.

- خوشهبندی

- رگرسیون

- طبقهبندی

- کاهش ابعاد

در واقع این ابزار، مجموعه گستردهای از الگوریتمها را در اختیار برنامهنویسان تازهکار و مجرب قرار میدهد.

سایکیتلرن بر اساس ابزارهایی همچون «SciPy»، نامپای و «Matplotlib» توسعه پیدا کرده است. بههمین دلیل، میتوان آن را بهسادگی با سایر ابزارهای تحلیل داده مرتبط با پایتون استفاده کرد.

پای تورچ

ابزار بعدی که معرفی میکنیم کتابخانه پایتورچ است که در زمینه یادگیری عمیق مورد استفاده قرار میگیرد. این ابزار توسط آزمایشگاه پژوهشهای هوش مصنوعی فیسبوک توسعه داده شده است و بهدلیل خصوصیاتی مانند انعطافپذیری یا انطباق با شرایط مختلف و همچنین راحتی در استفاده، نظر بسیاری از برنامهنویسان و پژوهشگران این حوزه را به خود جلب کرده است.

یکی از سودمندترین ویژگیهای پایتورچ، «گراف محاسباتی پویا» است که به توسعهدهنده امکان میدهد تا معماری مدل خود را در حین اجرای آن، اصلاح کرده و تغییر دهد. بدینترتیب، موقعیت خوبی برای انجام کارهای پژوهشی و آزمایشهای مرتبط بهوجود میآید. از دیگر ویژگیهای این ابزار اپنسورس میتوان به پشتیبانی قوی جامعه و مجموعه ابزارها و کتابخانههای در حال رشد آن اشاره کرد.

اگر قصد یادگیری پایتورچ را دارید مشاهده فیلم آموزش یادگیری عمیق با کتابخانه PyTorch در پایتون از فرادرس را به شما توصیه میکنیم که لینک آن نیز در ادامه آورده شده است.

در این قسمت با برخی از محبوبترین فریمورکهای پایتون در حوزه یادگیری ماشین و یادگیری عمیق آشنا شدید. اینکه کدام ابزار برای کار شما مناسبتر است، به نیازهای پروژه شما و کاری که قرار است انجام دهید بستگی دارد. بهطور کلی، اگر قصد ساخت مدلهای مرتبط با یادگیری عمیق را دارید، ابزارهای قدرتمندی مانند تنسورفلو و پایتورچ میتوانند برایتان مفید باشند. همچنین، برای الگوریتمها و مسائل پایهای یادگیری ماشین، سایکیتلرن یکی از مناسبترین ابزارها محسوب میشود. بهعنوان یک برنامهنویس هوش مصنوعی، یادگیری این ابزارها میتواند مجموعه مهارتهای شما را پربارتر کرده و در عین حال شما را در تولید اپلیکیشنهای بهتر هوش مصنوعی یاری دهد.

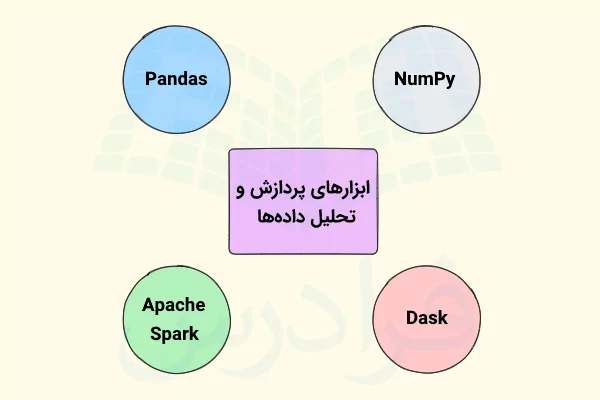

پردازش و تحلیل داده ها

در فرایند توسعه برنامههای هوش مصنوعی، زمانیکه با دادههای جدولی و حجیم رو به رو میشوید، لازم است از ابزارهای مناسبی استفاده کنید تا پردازش دادهها را بهطور کارآمد و مؤثر برایتان انجام دهند. پردازش داده مراحلی مانند پاکسازی، تبدیل و آمادهسازی دادهها را در بر میگیرد و بهطور معمول هنگامیکه بخواهیم دادهها را تحلیل کنیم یا هنگام استفاده از دادهها در مدلهای یادگیری ماشین، به سراغ این فرایند میرویم. در این قسمت با تعدادی از مهمترین ابزارهای تحلیل و پردازش دادهها آشنا خواهید شد.

پانداس

نخستین ابزار برای پردازش داده که در اینجا معرفی میکنیم کتابخانه پانداس است. ابزاری اپنسورس که توسط بسیاری از افراد برای تحلیل و دستکاری دادهها مورد استفاده قرار میگیرد. «دیتافریم» یکی از مهمترین ساختاردادههایی است که پانداس در اختیار شما قرار میدهد و بهوسیله آن میتوانید دادههایتان را بهراحتی تغییر داده و سازماندهی کنید. برخی از امکانات پانداس را در ادامه فهرست کردهایم.

- مدیریت دادههای گمشده و ناقص

- فیلتر کردن دادهها

- مرتبسازی دادهها

- انجام عملیات پیشرفته روی دادهها با دستوراتی ساده

علاوه بر موارد اشاره شده، استفاده از کتابخانه پانداس هنگامیکه با دادههای جدولی مانند فایلهای CSV و صفحات گسترده اکسل کار میکنید نیز برایتان بسیار سودمند خواهد بود.

نامپای

کتابخانه NumPy که نام آن از عبارت «Numerical Python» گرفته شده، ابزاری اپنسورس است که بهوسیله آن میتوانید با ماتریسها و آرایههای بزرگ و چند بُعدی کار کنید. نامپای توابع ریاضی گوناگونی را در اختیارتان قرار میدهد که میتوانید روی این آرایهها اعمال کنید. جالب است بدانید که برخی از کتابخانههای کاربردی پایتون در زمینه یادگیری ماشین و علم داده مانند پانداس و سایکیتلرن بر مبنای کتابخانه نامپای ساخته شدهاند.

Dask

اگر قصد انجام پردازش موازی را دارید، کتابخانه «Dask» میتواند در این زمینه برایتان مفید باشد. این ابزار اپنسورس با کمک به ابزارهای علم داده پایتون مانند پانداس و نامپای، به آنها امکان میدهد تا دیتاستهایی که بزرگتر از ظرفیت حافظه هستند را نیز مدیریت و پردازش کنند. نحوه کار به این شکل است که دیتاستهای حجیم را به قسمتهای کوچکتری تقسیم میکند تا با پردازش همزمان و موازی آنها، سرعت انجام تحلیل داده و وظایف مرتبط با آن را به میزان زیادی افزایش دهد.

آپاچی اسپارک

آپاچی اسپارک ابزاری تحلیلی است که بهکمک آن میتوان دادههای حجیم و بسیار بزرگ را پردازش کرد. این ابزار اپنسورس به کمک رایانش توزیع شده میتواند دیتاستهای حجیم را با سرعت زیادی پردازش و مدیریت کند. علاوه بر این، آپاچی اسپارک توانایی انجام پردازش دستهای، جریان بیدرنگ دادهای و تحلیلهای یادگیری ماشین را دارد. ضمن اینکه با زبانهای برنامهنویسی مختلفی همچون اسکالا، پایتون و جاوا نیز سازگار است.

مشاهده فیلم آموزش مقدماتی آپاچی اسپارک برای پردازش کلان داده از فرادرس که لینک آن نیز در ادامه آورده شده شما را در یادگیری این ابزار یاری میدهد.

در این قسمت با تعدادی ابزار مهم آشنا شدید که در زمینه پردازش و تحلیل داده بهکار میروند. اینکه کدامیک از این ابزارها برای پروژه شما مناسبتر است به مواردی مانند حجم دادهها و میزان پیچیدگی فرایندهای پروژه بستگی دارد. اگر دیتاست پروژه شما مقیاسی کوچک تا متوسط دارد، ابزارهایی مانند نامپای و پانداس میتوانند برایتان مناسب باشند. در غیر اینصورت، دادههای حجیمتر خود را میتوانید با استفاده از ابزارهایی مانند Dask و آپاچی اسپارک مدیریت کنید تا از طریق محاسبات توزیع شده و موازی پردازش شوند. آشنایی و بلد بودن کار با این ابزارها به شما کمک میکند تا دادههای اپلیکیشن AI خود را بهشکلی بهینه و کارآمد تحلیل کنید.

جمعبندی

در این مطلب از مجله فرادرس، مجموعهای از ابزارها، فناوریها و مفاهیم مهم و ضروری را به شما معرفی کردیم که برای تولید برنامههای مبتنی بر هوش مصنوعی و همچنین مدلهای بزرگ زبانی مورد استفاده قرار میگیرند. با در نظر گرفتن نیازهای پروژه مورد نظر و همچنین میزان تجربه خود میتوانید مناسبترین ابزارها را برگزینید. اگر تازهکار هستید، زبان پایتون و ابزارهای آن میتواند گزینه خوبی برای شروع باشد. ابزارهایی مانند کوبرنتیز و آپاچی اسپارک نیز در طرف دیگر برای پرداختن به پروژههای بزرگتر مناسبتر هستند.

مفاهیم مهمی مانند توکنسازی و امبدینگ نیز جزو و دیگر مواردی هستند که در این نوشتار به آنها پرداختیم و دانستن آنها به شما کمک میکند تا هنگام طراحی و ایجاد سیستمهای هوش مصنوعی تصمیمهای بهتری را اتخاذ کنید. تقویت مهارتها و مسلط شدن به ابزارها و مفاهیم بیان شده در این مطلب به شما امکان میدهد تا اپلیکیشنهای مجهز به هوش مصنوعی را بهشکل بهتر و مؤثرتری ایجاد، راهاندازی و مدیریت کنید. در نهایت باید بگوییم، با توجه به اینکه هوش مصنوعی با سرعت زیادی به پیش میتازد، ضروری است که بهطور مستمر به دنبال یادگیری و آشنایی با ابزارهای جدید باشید.

source