فرایند آموزش مدلهای یادگیری ماشین اغلب با ریسک مشکلاتی همچون بیشبرازش یا کمبرازش همراه است. به همین منظور، از رویکرد «منظمسازی» یا regularization برای تنظیم مدل و در نتیجه برازش بر دادههای جدید استفاده میشود. بهرهگیری از تکنیکهای منظمسازی برای به حداقل رساندن احتمال بیشبرازش و مطمئن شدن از عملکرد بهینه مدل ضرورت دارد. در این مطلب از مجله فرادرس یاد میگیریم regularization در یادگیری ماشین چیست و با انواع مختلف آن آشنا میشویم. رویکردی که در کنار سایر تدابیر، کسب بهترین نتایج ممکن را از مدلهای یادگیری ماشین تضمین میکند.

در این مطلب ابتدا یاد میگیریم منظور از regularization در یادگیری ماشین چیست، چگونه کار میکند و چه نقشی در یادگیری ماشین دارد. سپس با انواع منظمسازی یا regularization آشنا میشویم و به تعریف دو اصطلاح بیشبرازش و کمبرازش میپردازیم. در انتها این مطلب از مجله فرادرس دو مفهوم واریانس و سوگیری را معرفی میکنیم و از مزایا regularization در یادگیری ماشین میگوییم.

مفهوم regularization در یادگیری ماشین چیست؟

جلوگیری از بیشبرازش هدفی است که هنگام آموزش هر نوع مدل یادگیری ماشین به آن توجه ویژه میشود. مدل بیشبرازش شده دقت پایینی خواهد داشت. بهطور کلی، بیشبرازش زمانی اتفاق میافتد که مدل سعی بر یادگیری نویز و جزییات دیتاست داشته باشد. منظور از نویز، نقاط دادهایست که تنها رخدادی تصادفی به حساب آمده و نقشی در معرفی و ارائه ویژگیهای دیتاست ندارند. اگرچه آموزش دیدن با چنین دادههایی باعث افزایش انعطافپذیری مدل میشود اما، همزمان ریسک بیشبرازش نیز افزایش مییابد.

در حقیقت منظمسازی یا regularization نوعی رگرسیون است که در آن ضرایب مدل به صفر میل میکنند. به بیان دیگر این تکنیک برای جلوگیری از ریسک بیشبرازش، مدل را از یادگیری الگوهای پیچیده و دشوار منع میکند. یک معادله رگرسیون خطی ساده به شکل زیر است:

در این معادله نماد بیانگر مدل یادگیری و انواع نشان دهنده ضرایب تخمین زده شده برای متغیرها یا عوامل پیشبینی کننده مختلف () هستند. فرایند برازش شدن مدل شامل تابعی با عنوان «تابع زیان» است که به آن «مجموع مربعات خطا» (Residual Sum of Squares | RSS) نیز گفته میشود. در اینجا ضرایب به گونهای انتخاب میشوند که تابع زیان کمینه شود:

به این صورت، ضرایب مطابق با دادههای آموزشی تنظیم میشوند. اگر مجموعه آموزشی شامل نویز باشد، ضرایب مدل با دادههای جدید تطبیق پیدا نمیکنند. در چنین موقعیتی است که اعمال regularization باعث کاهش شدت این ضرایب میشود.

تکنیک regularization چگونه کار می کند؟

حالا که بهخوبی میدانیم منظور از regularization در یادگیری ماشین چیست، در این بخش به شرح نحوه کارکرد این تکنیک کاربردی میپردازیم. در فرایند منظمسازی، مقداری به عنوان جریمه به تابع زیانی که مدل قصد کمینه کردن آن را دارد اضافه میشود. این جریمه، مدل را مجبور به پایین نگه داشتن مقدار پارامترها (مانند مقادیر وزنی در شبکههای عصبی یا ضرایب در رگرسیون) میکند و به این شکل از وقوع بیشبرازش جلوگیری میشود. در ادامه، هر کدام از مراحل اجرا regularization را بهطور مجزا توضیح میدهیم. همچنین برای آشنایی بیشتر با نحوه انتخاب مدل در یادگیری ماشین، میتوانید فیلم آموزش انتخاب مدلهای یادگیری ماشین فرادرس را از طریق لینک زیر مشاهده کنید:

۱. تغییر تابع زیان

روند منظمسازی با ایجاد تغییر در تابع زیان آغاز میشود. تفاوت تابع زیان جدید و بهروز شده، در عبارت تعدیل کنندهایست که از افزایش بیش از حد مقدار پارامترها جلوگیری میکند. فرم کلی تابع زیان به شکل زیر است:

در عبارت فوق، نماد همان ضریب regularization است که توازن میان برازش دادهها و کمینه بودن پارامترها را برقرار میکند. مطلب جامع و مفصلتری درباره انواع توابع زیان در مجله فرادرس منتشر شده است که میتوانید آن را از طریق لینک زیر مطالعه کنید:

۲. انواع جریمه

در فهرست زیر به انواع جریمه در منظمسازی اشاره شده است:

- منظمسازی L1 (لاسو): عبارت جریمه در واقع همان جمع مقادیر مطلق پارامترها است. با استفاده از این روش، میتوان برخی از ضرایب مدل که مقداری برابر با صفر دارند را به راحتی حدف کرد.

- منظمسازی L2 (ستیغی): در اینجا عبارت جریمه برابر با مجموع مربع پارامترها است. در نتیجه جریمه بهطور مساوی میان پارامترها تقسیم شده و مقدار آنها را تا نزدیک به صفر – و نه دقیقا صفر – کاهش میدهد.

- «شبکه اِلاستیک» (Elastic Net): ترکیبی از دو روش L1 و L2 به حساب میآید. در واقع استفاده از این روش زمانی پیشنهاد میشود که نوعی همبستگی میان ویژگیها وجود داشته باشد یا بخواهیم همزمان از قابلیت انتخاب ویژگی L1 و کاهش پارامتر L2 بهرهمند شویم.

۳. تاثیر در فرایند آموزش

در طول آموزش و بهروزرسانی پارامترهای مدل، مقدار regularization به دو شیوه زیر تاثیرگذار است:

- مقدار جریمه () بالا باعث کوچکتر شدن پارامترهای مدل میشود و همزمان با کاهش ریسک بیشبرازش، احتمال کمبرازش شدن مدل وجود دارد.

- هر چه مقدار کوچکتر باشد، در حقیقت تغییری در پارامترها اعمال نشده و با افزایش پیچیدگی، احتمال بیشبرازش مدل نیز بالا میرود.

۴. برقراری توازن میان بیش برازش و کم برازش

انتخاب مقدار متناسب با مسئله بسیار حائز اهمیت است. دو حالت کلی از که باید از آنها اجتناب شود عبارتاند از:

- مقدار جریمه بیش از حد بالا موجب سادهسازی مدل و در نتیجه ناتوانی آن در شناسایی الگوهای مهم دیتاست میشود. رخدادی که آن را «کمبرازش» مینامند.

- اگر مقدار جریمه بیش از حد پایین باشد، ضرایب بزرگ به اندازه کافی جریمه نمیشوند و مدل، نویز زیادی را از مجموعه آموزشی استخراج میکند. شرایطی که تحت عنوان «بیشبرازش» شناخته میشود.

۵. پیاده سازی

در عمل مقدار بهینه و نوع regularization طی فرایند «اعتبارسنجی متقابل» (Cross Validation) انتخاب میشوند. در این فرایند، چند مدل مختلف با مقادیر متفاوتی از و همچنین نوع متفاوتی از regularization آموزش میبینند. با پایان کار، مدلی انتخاب میشود که بهترین عملکرد را داشته باشد.

آموزش یادگیری ماشین با فرادرس

یادگیری ماشین زیرشاخهای از هوش مصنوعی است که به سیستمهای کامپیوتری اجازه میدهد از طریق تجربه یاد بگیرند و عملکرد خود را بدون کمک انسان بهبود بخشند. این حوزه با استفاده از الگوریتمها و مدلهای آماری، به کامپیوترها امکان میدهد تا وظایف خاصی را بدون دستورالعملهای صریح انجام دهند. یکی از چالشهای مهم در یادگیری ماشین، مسئله بیشبرازش یا overfitting است.

بیشبرازش زمانی رخ میدهد که یک مدل بیش از حد به دادههای آموزشی وابسته شده و نتواند عملکرد خوب خود را به دادههای جدید تعمیم دهد. در اینجاست که regularization به کمک ما میآید. تکنیکی که با اضافه کردن ضرایبی ثابت، از بیشبرازش جلوگیری کرده و مدل را قادر میسازد تا الگوهای کلیتر و قابل تعمیمتری یاد بگیرد. اهمیت یادگیری ماشین در جهان امروز غیرقابل انکار است. از سیستمهای توصیهگر در پلتفرمهای آنلاین گرفته تا تشخیص بیماریها در پزشکی، از خودروهای خودران تا پردازش زبان طبیعی، یادگیری ماشین در همه جا کاربرد داشته و زندگی ما انسانها را متحول کرده است.

از همین جهت و برای ورود به این جهان هیجانانگیز و کسب مهارتهای لازم، فرادرس مجموعهای از فیلمهای آموزشی ارزشمند را تهیه و تولید کرده است که با مشاهده آنها از طریق بخش زیر، میتوانید گام به گام در مسیر تبدیل شدن به یک متخصص یادگیری ماشین قدم بردارید:

نقش regularization در یادگیری ماشین چیست؟

همانطور که تا اینجا در مورد آن صحبت شد، منظمسازی یا regularization نقش مهمی در توسعه و اجرا مدلهای یادگیری ماشین ایفا میکند. هدف از regularization را میتوان در کاهش پیچیدگی مدل، تطبیقپذیری بیشتر با دادههای جدید و رفع مشکلاتی چون «همخطی چندگانه» (Multicollinearity) و انتخاب ویژگی خلاصه کرد. از جمله کاربردهای regularization در یادگیری ماشین میتوان به موارد زیر اشاره داشت:

- جلوگیری از بیش برازش: مهمترین نقش regularization در یادگیری ماشین، جلوگیری از بیشبرازش مدل است. مشکل رایجی که بر اساس آن، مدل بیش از حد نسبت به مجموعه آموزشی حساس میشود. در نتیجه دقت مدل برای مجموعه آموزشی بسیار بالا و در مواجه با دادههای جدید بسیار پایین است. منظمسازی یا regularization با جریمه مقادیر وزنی بزرگ، احتمال بیشبرازش را کاهش میدهد.

- بهبود قابلیت تعمیمپذیری مدل: منظمسازی با سادهسازی مدل، باعث ارتقاء سطح عملکرد آن نسبت به دادههای آموزشی و جدید میشود. چنین مدلی بهجای تمرکز بر جزییات مجموعه آموزشی، الگوهای پایه دیتاست را شناسایی و استخراج میکند.

- مدیریت همخطی چندگانه: عمده کاربرد regularization زمانی است که همبستگی بالایی میان ویژگیها وجود داشته باشد. به عنوان مثال، منظمسازی L2 یا ستیغی مقدار بالا واریانس ضرایب را کاهش میدهد. به این صورت دقت پیشبینیهای مدل افزایش مییابد.

- انتخاب ویژگی: تکنیک منظمسازی L1 یا لاسو نقش مهمی در جریمه ضرایب مدل دارد. تا جایی که مقدار برخی از ویژگیها با صفر برابر شده و زیرمجموعه کوچکتری از ویژگیها باقی میماند. اهمیت این کاربرد زمانی مشخص میشود که انتخاب ویژگی امری لازم و ضروری برای سادهسازی و افزایش بهرهوری مدل باشد.

- پیشگیری از نویز: منظمسازی، حساسیت مدل را نسبت به ویژگیهای خاص مجموعه آموزشی مانند نویز و مقادیر پَرت کاهش میدهد و در عوض مدل بر ویژگیهای کاربردی و موثر در پیشبینی متمرکز میشود.

- تغییر واریانس به سوگیری: همزمان با کاهش احتمال بیشبرازش، تکنیک regularization سوگیری یا «بایاس» (Bias) مدل را افزایش میدهد. موازنهای که در صورت پیچیدگی بالا مدل میتواند مفید باشد.

- بهرهگیری از مدلهای پیچیده: با پیادهسازی regularization امکان استفاده از مدلهای پیچیدهتر مهیا میشود. برای مثال در شبکههای عصبی عمیق از تکنیک «حذف تصادفی» (Dropout) برای جلوگیری از بیش برازش کمک میگیرند.

- تسهیل همگرایی: منظمسازی از جمله رویکردهای مفید برای همگرایی سریع و راحتتر مدلهایی است که از تکنیک گرادیان کاهش استفاده میکنند.

انواع regularization در یادگیری ماشین

تا اینجا بهخوبی میدانیم نقش regularization در یادگیری ماشین چیست. تکنیک موثری در کاهش احتمال بیشبرازش، بهبود قابلیت تعمیمپذیری و مدیریت پیچیدگی مدل. تکنیکهای منظمسازی متنوعی در انواع مدلهای یادگیری ماشین مورد استفاده قرار میگیرند. برخی از رایجترین تکنیکهای regularization عبارتاند از:

- منظمسازی L1 (لاسو): با کاهش پارامترها و ضرایب مدل، نقش مهمی در فرایند انتخاب ویژگی دارد.

- منظمسازی L2 (ستیغی): در این تکنیک بهطور مساوی از ضرایب مدل کاسته میشود و در جلوگیری از همخطی چندگانه و حفظ پایداری مدل موثر است.

- شبکه اِلاستیک: زمانی از شبکه اِلاستیک استفاده میشود که همبستگی میان ویژگیها زیاد باشد یا بخواهیم از طریق کاهش پارامترها، انتخاب ویژگی متوازنی انجام دهیم.

- حذف تصادفی: انتخاب تصادفی زیرمجموعهای از ویژگیهای دیتاست، به شکلگیری شبکهای مقاوم در برابر بیشبرازش منجر میشود.

- «توقف زودهنگام» (Early Stopping): از طولانی شدن فرایند آموزش و در نتیجه بیشبرازش جلوگیری میکند. روشی ساده و اغلب کارآمد برای منظمسازی.

- «نرمالسازی دستهای» (Batch Normalization): با نرمالسازی نمونههای داده، دیگر نیازی به پیادهسازی انواع دیگر regularization و حذف تصادفی نیست.

- محدودیت وزنی: اینگونه مطمئن میشویم که مقادیر وزنی از یک حد مشخص فراتر نرفته و همراه با بهبود تعمیمپذیری مدل، احتمال بیشبرازش نیز به حداقل برسد.

- «داده افزایی» (Data Augmentation): شاید از نظر ریاضیاتی چندان شباهتی با انواع دیگر منظمسازی نداشته باشد اما با افزایش مصنوعی اندازه دیتاست، باعث تعمیمپذیری بهتر مدل میشود.

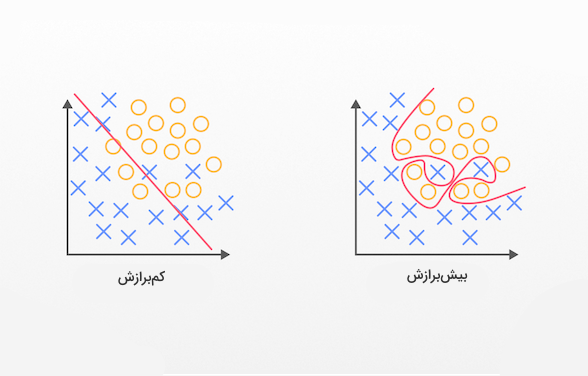

بیش برازش و کم برازش چیست؟

دو اصطلاحی که در این مطلب از مجله فرادرس به تکرار از آنها نام بردهایم. با این حال و از آنجا که اهمیت بیشبرازش و کمبرازش در یادگیری ماشین و موضوعاتی همچون regularization بسیار زیاد است، در ادامه به تعریف و توضیح این دو مفهوم مهم میپردازیم.

بیش برازش

مدل زمانی بیشبرازش میشود که بیش از حد تحت تاثیر جزییات مجموعه آموزشی قرار بگیرد و نتواند عملکرد قابل قبولی نسبت به دادههای جدید ارائه دهد. در نتیجه پیچیدگی مدل افزایش یافته و قادر به تشخیص الگوهای عمومی و رایج سایر دیتاستها نخواهد بود. از جمله ویژگیهای بیشبرازش میتوان به موارد زیر اشاره داشت:

- دقت بالا برای مجموعه آموزشی و دقت پایین برای مجموعه اعتبارسنجی یا آزمون.

- یادگیری جزییات و ساختار پایه مجموعه داده آموزشی.

- زمانی رخ میدهد که پیچیدگی مدل نسبت به حجم دادههای ورودی بالا باشد.

اغلب، مدل به دلایل زیر بیشبرازش میشود:

- تعداد زیاد پارامترها (پیچیدگی بالا).

- تعداد کم دادههای آموزشی.

- عدم استفاده از regularization.

- آموزش مدل برای «دورههای» (Epochs) زیاد یا عدم بهرهگیری از روش توقف زودهنگام.

برای جلوگیری از بیشبرازش روشهای زیادی پیشنهاد میشوند. از جمله:

- سادهسازی مدل با کاهش تعداد پارامترها یا استفاد از مدلی با پیچیدگی کمتر.

- افزایش حجم مجموعه آموزشی.

- استفاده از تکنیکهایی مانند L2، L1 و حذف تصادفی.

- پیادهسازی رویکردی مانند اعتبارسنجی متقابل برای اطمینان از دقت بالا مدل نسبت به دادهها جدید.

- اجرا روش توقف زودهنگام در طول فرایند آموزش.

کم برازش

در طرف مقابل، سادگی بیش از حد مدل باعث ناتوانی آن در شناسایی الگوهای ساختاری و ایجاد مشکل کمبرازش میشود. از همین جهت، مدل یادگیری ماشین نمیتواند بر دادههای آموزشی مسلط شده و در برابر دادههای جدید نیز عملکرد خوبی به نمایش نمیگذارد. برخی از خصوصیات کمبرازش عبارتاند از:

- عملکرد ضعیف در مواجهه با دادههای آموزشی و جدید.

- سادگی بیش از حد مدل و ضعف در یادگیری الگوهای پایه دیتاست.

همچنین به عنوان برخی از دلایل ایجاد کم برازش، موارد زیر را در نظر داشته باشید:

- تعداد کم پارامترهای مدل.

- استفاده از ویژگیهای نامناسب برای شناخت مجموعه داده.

- تعیین مقدار جریمه بالا در regularization.

برای رفع کمبرازش میتوان راهکارهای زیر را بهکار گرفت:

- افزایش پیچیدگی مدل با بهرهگیری از پارامترهای بیشتر یا انتخاب مدلی پیچیدهتر.

- ایجاد ویژگیهای بیشتر یا استفاده از تکنیکهای استخراج و انتخاب ویژگی.

- کاهش مقدار جریمه تکنیک منظمسازی.

- اطمینان از تکمیل روند آموزش مدل و تغییر پارامترهای آموزشی مانند تعداد دورهها یا «نرخ آموزش» (Learning rate).

یافتن توازن میان بیشبرازش و کمبرازش در توسعه مدلهای یادگیری ماشین امری مهم و کلیدی است. فرایندی که شامل تنظیم میزان پیچیدگی مدل، پردازش دادهها، انتخاب ویژگیهای مناسب و بهکارگیری تکنیکهایی مانند regularization میشود. هدف از منظمسازی، طراحی و ساخت مدلی است که همزمان با حفظ عملکرد خوب نسبت به دادههای آموزشی، دقت بالایی در شناسایی دادههای جدید داشته باشد.

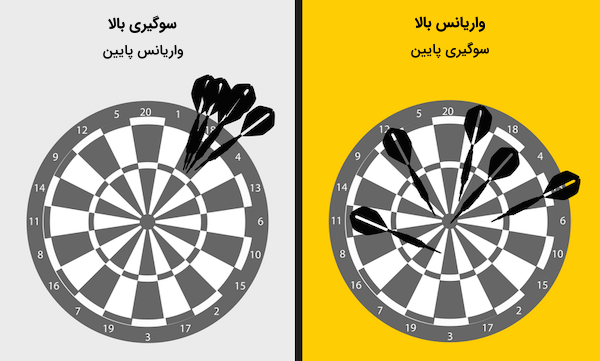

معرفی دو مفهوم واریانس و سوگیری

درک «واریانس» و «سوگیری» به عنوان دو مفهوم اساسی و مهم یادگیری ماشین، در تشخیص عملکرد مدل و برقراری تعادل میان بیشبرازش و کمبرازش ضروری است. از همین جهت در ادامه این بخش، توضیح بیشتری از واریانس و سوگیری ارائه میدهیم.

واریانس

میزان تغییری که هنگام بهرهگیری از دادههای آموزشی مختلف در پیشبینیهای مدل اتفاق میافتد. به بیان سادهتر، واریانس نشان دهنده پراکندگی پیشبینیهای مدل از مقدار میانگین است. شرایطی که باعث بیشبرازش و تمرکز بیش از حد مدل بر دادههای آموزشی میشود. برخی از ویژگیهای واریانس عبارتاند از:

- اندازهگیری میزان نوسان و تغییر پیشبینیهای بهدست آمده از مدلهای متفاوت.

- واریانس بالا ممکن است مدل را به استخراج نویز از دادههای آموزشی وادار کرده و عملکرد ضعیفی در برابر دادههای جدید حاصل شود.

سوگیری

زمانی از اصطلاح «سوگیری» در یادگیری ماشین استفاده میشود که مدل قادر به درک و تشخیص پیچیدگیهای مسئله نباشد. نادیده گرفتن روابط مهم میان ویژگیهای ورودی و خروجی به مشکل کمبرازش منتهی میشود. در فهرست زیر به چند مورد از خصوصیات سوگیری اشاره شده است:

- منظور از سوگیری یا «بایاس» (Bias)، اختلاف بین پیشبینی مورد انتظار از مدل و مقادیر حقیقی است. مدلهایی که سوگیری بالا داشته باشند اغلب با مشکل کمبرازش مواجه میشوند.

- سوگیری بالا باعث سادگی بیش از حد مدل شده و قادر به یادگیری از دادههای پیچیده نخواهد بود.

ارتباط میان واریانس و بایاس را «موازنه بایاس-واریانس» (Bias-Variance Tradeoff) مینامند. در حقیقت مدل زمانی کمبرازش میشود که بیش از حد ساده بوده و در کنار بایاس بالا، واریانس پایینی داشته باشد. از طرف دیگر، اگر پیچیدگی مدل زیاد بوده و علاوهبر بایاس پایین، واریانس بالایی داشته باشد، یعنی بیشبرازش شده است. حالتی ایدهآل است که هم بایاس و هم واریانس کمینه باشند. در فهرست زیر چهار حالت ممکن از مقادیر واریانس و بایاس را ملاحظه میکنید:

- بایاس بالا، واریانس پایین: دقت مدل پایین و بیش از حد سادهسازی شده است.

- بایاس پایین، واریانس بالا: بهطور میانگین دقت مدل بالا بوده اما نتایج متفاوت و ناپایداری برای هر دیتاست ارائه میدهد. پیچیدگی این دست از مدلها بسیار بالا است.

- بایاس پایین، واریانس پایین: دقت و پایداری مدل هم برای دادههای آموزشی و هم جدید زیاد است و توازن خوبی میان پیچیدگی مدل و عملکرد آن نسبت به نمونههای از پیش دیده نشده برقرار خواهد بود.

- بایاس بالا، واریانس بالا: دقت و ثبات مدل نسبت به دادههای آموزشی و جدید پایین است.

مزایا regularization در یادگیری ماشین چیست؟

حالا که میدانیم regularization در یادگیری ماشین چیست، چگونه کار میکند و با مفاهیمی مانند بیشبرازش، کمبرازش، واریانس و سوگیری نیز آشنا شدیم، در این بخش و فهرست زیر به تعدادی از مزایا منظمسازی اشاره میکنیم:

- کاهش بیشبرازش: منظمسازی، مدل را از بیشبرازش و یادگیری اطلاعات بیارزش مجموعه آموزشی دور نگه میدارد.

- بهبود تعمیمپذیری: تکنیک regularization باعث سادهسازی مدلها و تضمین عملکرد بهتر در مقابل دادههای جدید میشود.

- افزایش ثبات و پایداری: ایجاد ثبات در فرایند آموزش مدل با جریمه ضرایب بزرگ.

- امکان انتخاب ویژگی: با استفاده از روش منظمسازی L1 برخی از ضرایب صفر شده و تنها زیرمجموعه برگزیدهای از ویژگیها باقی میمانند.

- رفع همخطی چندگانه: کاهش همبستگی میان ویژگیها و کارآمد در مدلهای خطی.

- سادهسازی: جلوگیری از بیشبرازش و ارتقاء سطح تفسیرپذیری با سادهسازی مدلهای یادگیری ماشین.

- مدیریت میزان پیچیدگی مدل: ارائه مکانیزمی برای ایجاد تعادل میان پیچیدگی مدل و عملکرد آن نسبت به دادههای ورودی.

- کاهش حساسیت مدل: بهکارگیری regularization در یادگیری ماشین، تضمینی برای کاهش حساسیت مدل نسبت به نمونههای خاص مجموعه آموزشی است.

- همگرایی سریعتر: الگوریتمهای بهینهسازی را قادر میسازد تا راحت و سریعتر به خطا کمینه دست پیدا کنند.

- تنظیم سطح پیچیدگی: از جمله مواردی که رویکرد منظمسازی را متمایز میسازد، قابلیت تغییر مقدار جریمه و تنظیم سطح پیچیدگی مدل نسبت به پیشنیازهای مسئله است.

تکنیک regularization نقشی مهمی در شبکههای عصبی و یادگیری عمیق ایفا میکند. در این حوزهها که مدل اغلب بسیار پیچیده و دارای پارامترهای زیاد است، خطر بیشبرازش بهشدت افزایش مییابد. اما با استفاده از روشهایی مانند منظمسازی L1 و L2، حذف تصادفی و توقف زودهنگام میتوان پیچیدگی مدل را کنترل و از فراگیری جزییات مجموعه آموزشی جلوگیری کرد. استفاده از این تکنیکها باعث میشود شبکههای عصبی الگوهای موثر دیتاست را یاد گرفته و عملکرد قابل قبولی در برابر دادههای جدید داشته باشند.

برای درک عمیقتر این مفاهیم و کسب تجربه بیشتر، مشاهده فیلم آموزشی و پروژهمحور زیر را از وبسایت فرادرس به شما پیشنهاد میکنیم:

جمعبندی

تسلط بر تکنیکهای منظمسازی برای تمام افراد فعال در حوزه هوش مصنوعی و یادگیری ماشین یک ضرورت است. در این مطلب از مجله فرادرس خواندیم و یاد گرفتیم که منظور از regularization در یادگیری ماشین چیست و چگونه درک و پیادهسازی روشهای مختلف منظمسازی میتواند بر عملکرد مدل و کامل شدن دید ما نسبت به اصول یادگیری ماشین تاثیر بگذارد. چه با مشکلاتی همچون بیشبرازش و کمبرازش مواجه بوده و چه قصد بهبود ثبات و دقت مدل را داشته باشید، انواع مختلف regularization، ابزارهای متنوعی را برای غلبهبر این چالشها در اختیار شما قرار میدهند.

source