در عصر اطلاعات، بسیاری نمیتوانند زمان پیش از تلفنهای همراه و جریان پایدار اطلاعات را تصور کنند. با گذشت دههها پژوهش نوآورانه و پیشرفتهای فنی، جهش چشمگیری را از مبانی اولیه و نظری یادگیری ماشین تا تاثیر متحول کننده آن در جوامع مدرن امروز شاهد بودهایم. تاریخچه یادگیری ماشین منعکس کننده سفر ماجراجویی انسان برای ساخت کامپیوترهایی شبیه به خود است. ماشینهایی که قادر به یادگیری باشند و بتوانند تصمیمات هوشمندانه بگیرند. ماجراجویی که صنایع مختلف را متحول، تعاملات میان انسان و کامپیوتر را بازتعریف و عصری تازه از فرصتهای بینظیر را آغاز کرده است. در این مطلب از مجله فرادرس، با مفاهیم اولیه هوش مصنوعی آشنا شده و نگاهی به تاریخچه یادگیری ماشین از ابتدا تا به امروز خواهیم داشت.

در این مطلب، پس آشنایی با مفهوم یادگیری ماشین و اصول اولیه این حوزه، به بررسی چالشهای هوش مصنوعی در طول تاریخ میپردازیم. سپس تکامل برخی از مهمترین الگوریتمهای یادگیری ماشین را مرور کرده و نگاهی به چگونگی معرفی و گسترش مجموعهدادههای بزرگ میاندازیم. در انتهای این مطلب از مجله فرادرس، شرح مختصری از شبکههای عصبی و یادگیری عمیق ارائه داده و با رویدادهای مهم تاریخچه یادگیری ماشین از ابتدا تا به امروز آشنا میشویم.

یادگیری ماشین چیست؟

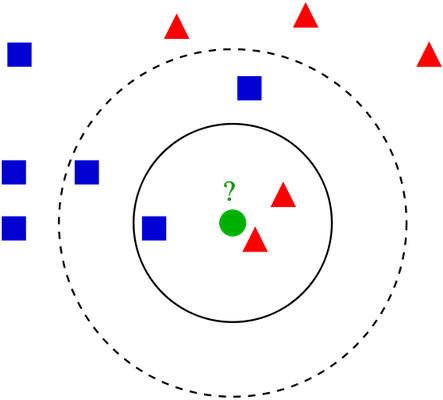

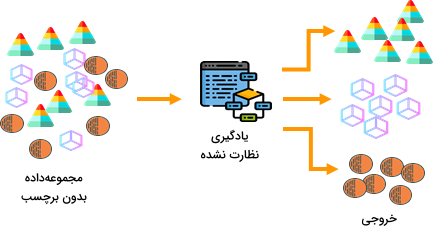

یادگیری ماشین یعنی توسعه و استفاده از سیستمهای کامپیوتری که بدون نیاز به هدایت و راهنمایی، خود به خود یاد گرفته و با محیط تطبیق پیدا میکنند. سیستمهایی که از الگوریتمها و مدلهای آماری برای تجزیه و تحلیل و تولید خروجی از الگوهای موجود در دادهها استفاده میکنند. یادگیری ماشین، نقش بسیار مهمی در تکنولوژیهایی که امروزه با نام هوش مصنوعی از آنها یاد میشود دارد. به عنوان مثال، «هوش مصنوعی مولد» (Generative AI) در واقع از یادگیری ماشین در قالب «مدلهای زبانی بزرگ» (Large Language Models | LLMs) سرچشمه میگیرد. مدلهای یادگیری ماشینی که به بررسی حجم زیادی از داده برای کشف الگوهای موجود در واژگان و عبارات متنی میپردازند. بسیاری از کاربردهای بیسابقه هوش مصنوعی در کسبوکار و همچنین جامعه، بهخاطر قابلیتهای گسترده یادگیری ماشین ممکن شده است.

ازجمله این کاربردها میتوان به تصویرپردازی پزشکی، تحلیل آماری شبکههای اجتماعی، ارزیابی خطرات یا پیشبینی شکست، مسیریابی و دفع حملات سایبری یاد کرد. گستره تاثیرگذاری یادگیری ماشین وسیع بوده و بسیاری از صنایع را مانند تبلیغات، تولید، امور مالی، بیمه و مواد دارویی دربرمیگیرد.

مفاهیم و اصول اولیه

شاید به هوش مصنوعی و بهطور دقیقتر یادگیری ماشین به عنوان فناوریهایی نوظهور نگاه کنید. اما حقیقت این است که توسعه هوش مصنوعی تاریخچه قدیمیتری دارد. مانند هر دستاورد علمی دیگری، یادگیری ماشین نیز حاصل تلاش افراد زیادی بوده و تنها توسط یک نفر طراحی و ساخته نشده است. همزمان با شکلگیری مفهوم محاسبات، انسان سعی کرد آن را با پیچیدهترین سیستمی که میشناسد یعنی مغز خود مقایسه کند.

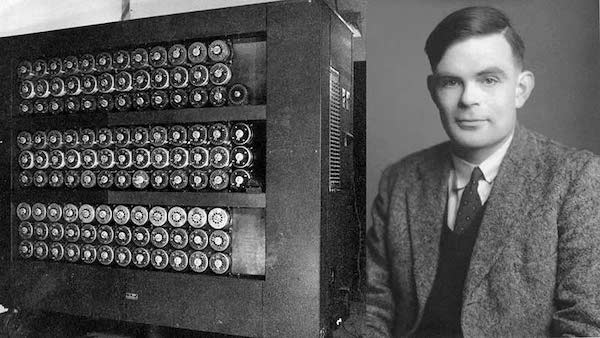

تست تورینگ

ریاضیدان و مبدع علوم کامپیوتر «آلن تورینگ» (Alan Turing)، تاثیر بهسزایی بر شروع یادگیری ماشین داشت. او ایده «تست تورینگ» (Turing Test) را اولین بار در مقالهای با عنوان «ماشین محاسباتی و هوش» (Computing Machinery and Intelligence) در سال ۱۹۵۰ منتشر کرد. فرآیندی که توانایی ماشین در تقلید رفتار و هوش انسانگونه را آزمایش میکند. در این آزمایش، اگر ماشین بتواند به گونهای مکالمات انسانی را تقلید کند که فرد ناظر نتواند تمایزی میان پاسخهای انسان و ماشین قائل شود، یعنی موفق بوده است. در تست تورینگ فردی ناظر بهصورت متنی، همزمان با یک انسان و یک ماشین مکالمه میکند. فرآیندی که به آن «بازی تقلید» (Imitation Game) نیز گفته میشود. هدف ناظر تشخیص انسان از ماشین است و اگر نتواند بهطور مداوم و بر اساس مکالمات، متوجه تفاوت میان انسان و ماشین شود، ماشین در تست تورینگ قبول میشود؛ یعنی سطح هوش مصنوعی و مهارتهای محاورهای آن با انسان برابری میکند.

با این حال، این آزمون ممکن است برای هر شخص متفاوت باشد. شاید فردی با آگاهی قبلی بداند که پاسخها مربوط به مدل زبانی است که بر روی حجم عظیمی از دادههای زبان انسان آموزش دیده است. باید از خود بپرسیم که آیا تنها تقلید زبان انسان برای آنکه موجودیتی را هوشمند بنامیم کافیست و آیا میتوان، عملکرد یک نمونه خاص را ملاک قرار داد و آن را برابر با سطح هوش انسانی دانست. صرفنظر از انتقادات، چنین آزمایش فکری، آن هم در سال ۱۹۵۰ و اوایل علم محاسبات، تاثیر بزرگی بر نگرش انسان به توانایی ماشین داشت. سیستمهایی که نه تنها قادر به اندیشیدن هستند بلکه، بهجای ما نیز فکر کرده و تصمیم میگیرند.

بازی چِکرز

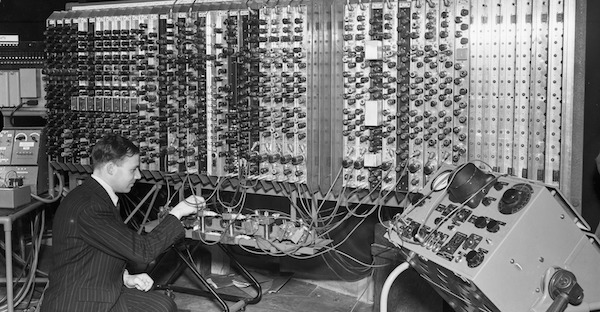

«آرتور ساموئل» (Arthur Samuel) ازجمله پیشتازان حوزه هوش مصنوعی و علوم کامپیوتر بود. او در شرکت «آیبیاِم» (IBM) کار میکرد و اغلب به عنوان مخترع یکی از اولین نمونه «ماشینهای خودآموز» (Self-learning Machines) شناخته میشود. نرمافزار ساموئل در سالهای ۱۹۵۲ تا ۱۹۵۵ بر روی کامپیوترهای IBM توسعه داده شد. این نرمافزار بازی «چکرز» (Checkers) را به دفعات زیاد مقابل خود انجام میداد و به تدریج و با آزمون و خطا، استراتژیهای خود را بهبود میبخشید. همزمان با زیاد شدن تعداد بازیهای انجام شده توسط نرمافزار، به حجم پایگاه دادهای که شامل موقعیتها و بهترین حرکات متقابل بود نیز اضافه میشد.

این برنامه از پایگاه داده برای تصمیمگیری در بازیهای آینده استفاده میکرد. با گذشت زمان، نرمافزار به قدری پیشرفت کرد که میتوانست با انسان نیز بازی کند و حتی گاهی برنده شود. پژوهش آرتور ساموئل در زمینه بازی چکرز نقطه عطف درخشانی در تاریخ یادگیری ماشین است. پژوهشی که نشان داد کامپیوترها نه تنها میتوانند یاد بگیرند بلکه، این توانایی را دارند تا با تکرار و خودآموزی، در انجام فعالیتی خاص حرفهای شوند. این پروژه در حقیقت سنگ بنایی برای پیشرفتهای بعدی در الگوریتمها و روشهای یادگیری ماشین بود و به خوبی توانست کاربردهای عملی هوش مصنوعی در زمینههایی فراتر از محاسبات را به نمایش بگذارد.

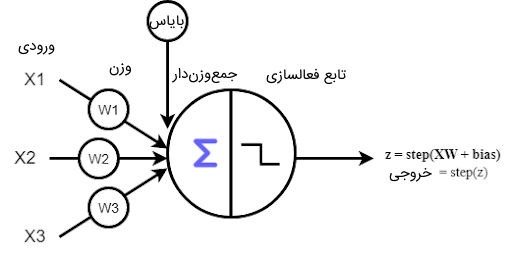

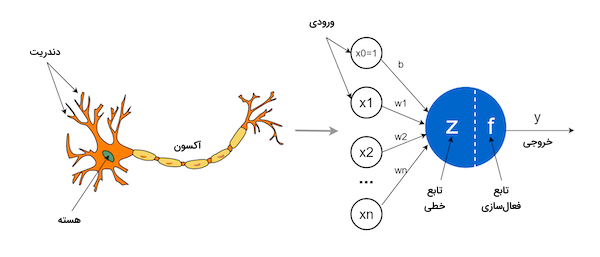

شبکه عصبی پرسپترون

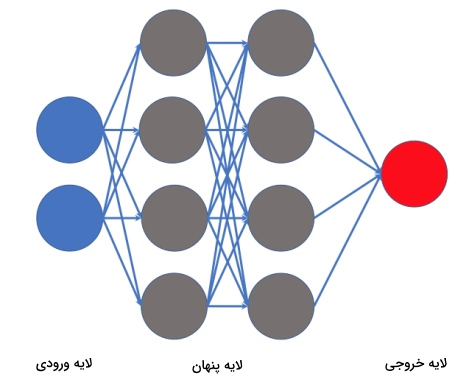

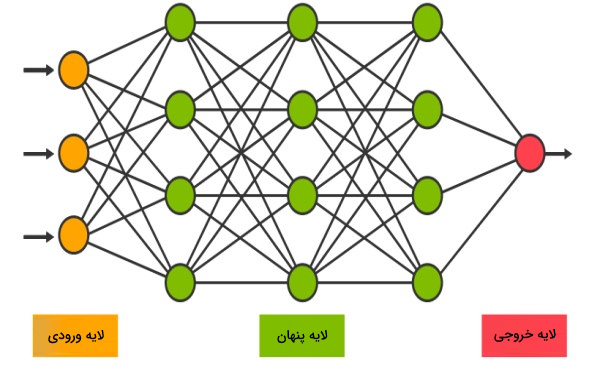

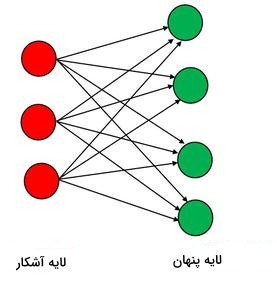

از «پرسپترون» (Perceptron) به عنوان یکی از اولی مدلهای شبکه عصبی بسیار موثر در تاریخ یادگیری ماشین و بهطور کلی هوش مصنوعی یاد میشود. شبکه عصبی پرسپترون در اواخر دهه ۵۰ میلادی توسط «فرانک روزنبلات» (Frank Rosenblatt)، به عنوان تلاشی برای ساخت مدل محاسباتی قادر به تقلید عملکرد نورون زیستی معرفی شد. در ابتدا قرار بود پرسپترون نوعی کامپیوتر باشد اما به تدریج، تبدیل به الگوریتمی برای یادگیری نظارت شده در «دستهبندهای دودویی» (Binary Classifiers) شد. پرسپترون مدل ریاضیاتی ساده شدهای از یک نورون است. هر نورون چند ورودی دارد و آنها را پس از ضرب کردن در پارامترهای وزنی با یکدیگر جمع کرده و در نهایت با اعمال یک «تابع فعالسازی» (Activation Function) بر نتیجه، خروجی نورون را تولید میکند. از این خروجی میتوان به عنوان ورودی در لایههای بعدی و تصمیمگیریهای آینده استفاده کرد. توانایی تطبیق پیدا کردن بر اساس دادههای ورودی و خروجی هدف، نوآوری اصلی شبکه عصبی پرسپترون بود. فرآیند تنظیم پارامترهای وزنی از طریق یک الگوریتم یادگیری به نام «قاعده یادگیری پرسپترون» (Perceptron Learning Rule) انجام میشود. این الگوریتم بهمنظور کاهش اختلاف میان نتیجه اصلی و خروجی پیشبینی شده، وزنها را بهروزرسانی کرده و به پرسپترون اجازه میدهد تا از اشتباهات یاد گرفته و موجب بهبود عملکرد خود شود.

در حالی که پرسپترون شبکهای تک لایه است، ساختار و قواعد یادگیری آن، الهام بخش طراحی ساختارهای عصبی پیچیدهتری مانند «شبکههای عصبی چند لایه» (Multi-layer Neural Networks) بوده است. این شبکه عصبی نمایانگر مفهوم یادگیری ماشین از دادهها و تنظیم مکرر پارامترها به منظور ارتقاء عملکرد است. پرسپترون با تغییر جریان از سیستمهای «قاعده محور» (Rule-Based) قدیمی، ایده یادگیری ماشین را از طریق مشاهده داده بنا نهاد. با این حال، پرسپترون محدودیتهایی داشت و تنها میتوانست الگوهای قابل جداسازی خطی را یاد بگیرد. در نتیجه، پرسپترون در مواجهه با مسائلی که نیازمند «مرزهای تصمیم» (Decision Boundaries) غیرخطی هستند، با چالش روبهرو است. از این موضوع که بگذریم، معرفی شبکه عصبی پرسپترون و روند توسعه پس از آن، نقش حیاتی در تاریخچه یادگیری ماشین داشت. شبکه عصبی که فرصت کشف ساختارهای عصبی پیچیدهتر و قواعده «یادگیری تقویتی» (Reinforcement Learning) را ممکن ساخت و باعث شد تا بار دیگر در دهه ۸۰ میلادی، شبکههای عصبی به موضوعی جذاب برای پژوهش تبدیل شوند.

زمستان هوش مصنوعی

زمستان هوش مصنوعی به بازهای از تاریخ اشاره دارد که سرمایهگذاریها کم شده بود، علاقه چندانی به پژوهش در این زمینه وجود نداشت و بهطور کلی، روند پیشرفت در حوزه هوش مصنوعی و زیر شاخههای آن ازجمله یادگیری ماشین آهسته شده بود. این رویداد در زمانی به وقوع پیوست که پیشبینیها و انتظارات از قبل تعیین شده نسبت به توسعه سیستمهای هوشمند محقق نشدند. در نتیجه، دیگر به ندرت سرمایهگذاری در تحقیقات این حوزه انجام میشد و اغلب، در کاربردی بودن اهداف معین شده برای هوش مصنوعی تردید داشتند.

اولین زمستان: اواسط دهه ۷۰ و اوایل دهه ۸۰ میلادی

موج خوشبینی اولیه نسبت به قابلیتهای هوش مصنوعی در دهه ۵۰ شروع و در دهه ۶۰ میلادی به اوج خود رسید. با این حال، امکانات و تکنولوژی موجود در آن زمان، با اهداف تعیین شده توسط محققان هوش مصنوعی هماهنگ نبود. قدرت محاسباتی محدود، مانع دستیابی به پیشرفتهای مورد انتظار در آن زمان شد. پژوهشها در زمینههایی مانند درک زبان طبیعی، «تشخیص تصویر» (Image Recognition) و «استدلال عقلانی» (Commonsense Reasoning) با مشکل روبهرو شده بودند. همین امر موجب شده بود تا منابع مالی مورد نیاز برای تحقیقات حوزه هوش مصنوعی، هم از طرف دولتها و هم صنایع محدود و هوش مصنوعی، نوعی فناوری فانتزی و غیر واقعی قلمداد شود. اولین زمستان هوش مصنوعی نتیجهای جز کاهش پروژههای هوش مصنوعی، علاقه آکادمیک و عقب راندن ابتکارات هوشمند نداشت.

دومین زمستان: اواخر دهه ۸۰ و دهه ۹۰ میلادی

دومین زمستان هوش مصنوعی، بهدنبال همان خوشبینی بیش از حد و انتظارت برآورده نشده به وقوع پیوست. در این بازه زمانی، پژوهشگران به درک مشترکی رسیدند که فناوریهای مرتبط در این حوزه هنوز به نهایت قابلیتهای خود نرسیده و از طرفی، پیشرفت کاربردی چشمگیری نیز رخ نداده است. بار دیگر از میزان سرمایهگذاریها برای پژوهش در این زمینه کاسته شد و سازمانها اعتماد خود را برای سرمایهگذاری در فناوریهایی که در سابق نتوانسته بودند به نتایج قابل توجهی منجر شوند از دست داده بودند. بسیاری از پروژههای هوش مصنوعی با مشکلاتی همچون پیچیدگی بیش از حد و «مقیاسپذیری» (Scalability) دست و پنجه نرم میکردند. از همین جهت، پژوهشگران تمرکز خود را از «هوش مصنوعی عمومی» (General AI) برداشته و در عوض بر اهدافی کوچکتر متمرکز شدند.

البته باید به این نکته نیز اشاره کرد که با وجود همه دشواریها، هنوز هم تحقیقات ادامه داشت. تحقیقاتی که به مرور باعث پرورش خود اندیشی شده، روشهای پیشین را بهبود بخشیده و انتظارات واقعگرایانهتری توسعه دادند. در نهایت، این دو زمستان تمام شد و هوش مصنوعی با درسهایی ارزشمند، تمرکز بر اهداف قابل دستیابی و علایقی بهروز شده از آن بیرون آمد. فرایندی که راه را برای پیشرفت هوش مصنوعی و یادگیری ماشین در قرن ۲۱ هموار کرد.

تکامل الگوریتم ها

در اولین قدمها، پس از گذر از چالشهای زمستان اول در اواخر دهه ۶۰ و اوایل دهه ۷۰ میلادی، محققان بر کاربردهایی خاص ازجمله «سیستمهای خبره» (Expert Systems) متمرکز شدند. با استفاده از این سیستمها میتوان توانایی تصمیمگیری متخصصین هر حوزه را از طریق «منطق نمادین» (Symbolic Logic) شبیهسازی کرد و از قواعد آن برای نمایش دانش بهره گرفت. با «کُدبندی» (Encoding) فرایندهای مختلف در قالب قواعد شرطی if و then، سیستمهای خبره با تصمیمگیری «قاعده-محور» (Rule-Based) در حوزههای مختلف تطبیق پیدا کردند. اگر چه باید در نظر داشت که این سیستمها در کنترل شرایط نامشخص و تطبیقپذیری با اطلاعات جدید عملکرد چندان خوبی از خود به نمایش نمیگذارند.

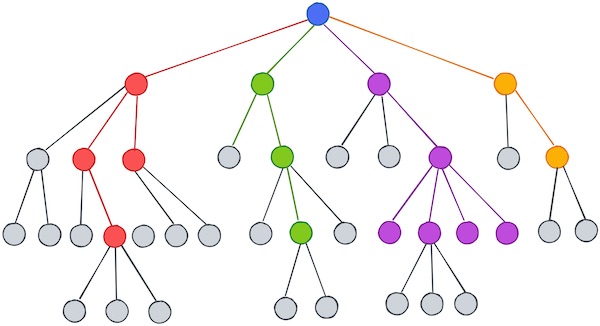

درخت تصمیم

در پاسخ به مشکلات سیستمهای خبره و در اوایل دهه ۷۰ میلادی، مفهوم «درخت تصمیم» (Decision Tree) معرفی شد. درخت تصمیم روشی داده-محور و خودکار را از فرایند تصمیمگیری ارائه داد. ساختارهایی سلسلهمراتبی که دنبالهای از تصمیمات و نتایج مربوطه را به تصویر میکشند. هر «گره» (Node) نشانگر یک تصمیم است و گرههای پایانی یا «برگ» (Leaf Nodes) نشاندهنده خروجیها یا نتایج دستهبندی هستند. در درخت تصمیم هدف، انتخاب ویژگیهایی است که بیشترین نقش را در دستهبندی نهایی داشته و برای کاربر نهایی قابل فهم هستند. این الگوریتم، توانایی هوش مصنوعی و یادگیری ماشین را در ترکیب تجربیات انسان با تصمیمگیری مبتنی بر داده به نمایش گذاشت. روشی که پس از گذشت زمان، بهخاطر کارآمدی زیاد، همچنان مورد استفاده قرار میگیرد. همزمان با دگرگون شدن چشمانداز هوش مصنوعی، این توسعه زودهنگام، پایهگذار روشهای پچیده آینده مانند «روشهای گروهی» (Ensemble Methods) و «یادگیری عمیق» (Deep Learning) بود و تحولی در تاریخچه یادگیری ماشین ایجاد کرد.

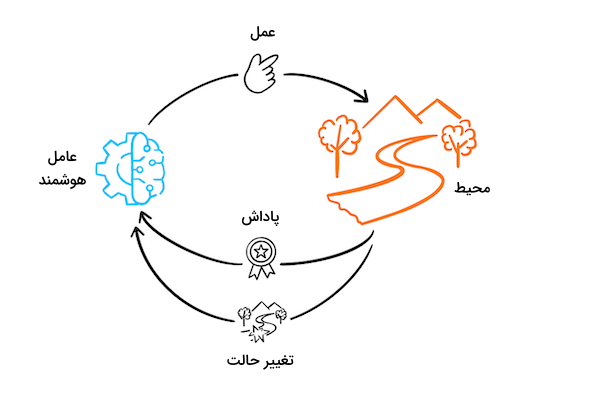

یادگیری تقویتی و مدل مارکوف

در ابتدا، یادگیری تقویتی به عنوان جایگزینی برای سیستمهای قدیمی قاعده-محور معرفی شد. در یادگیری تقویتی بر توانایی عامل هوشمند در تعامل با محیط و یادگیری از طریق آزمون و خطا تاکید میشود. یادگیری تقویتی رویکردی الهام گرفته از علم روانشناسی و «شرطیسازی عامل» (Operant Conditioning) است که رفتار عاملهای هوشمند را از طریق بازخوردهایی در قالب «پاداش» (Reward) و «مجازات» (Penalty) کنترل میکند. در دهه ۵۰ میلادی، پژوهش ماندگار آرتور ساموئل در تاریخچه یادگیری ماشین به خوبی نشان داد که چگونه یک عامل هوشمند میتواند با انجام بازی مانند چکرز در مقابل خودش، در کاری ماهر شده و به مرور زمان استراتژیهای بهتری پیدا کند. همزمان مفهوم مدلهای مارکوف، بهطور خاص «فرایند تصمیمگیری مارکوف» (Markov Decision Process | MDP)، چارچوب ریاضیاتی ارزشمندی برای مدلسازی تصمیمگیری «ترتیبی» (Sequential) مهیا کرد. ایده مدلهای مارکوف بر این پایه استوار است که موقعیت آینده یک سیستم، تنها به موقعیت فعلی وابسته است و ارتباطی با حالات گذشته آن ندارد. «زنجیره مارکوف» (Markov Chain) نمایشی ساده از این ایده است که در آن تنها مرحله فعلی برای قدم بعدی اهمیت دارد.

ساز و کار MDP دید بهتری از نحوه تعامل عاملهای هوشمند با محیط و دریافت پاداش ارائه داد و زمینهساز حل چالشهای موجود در یادگیری تقویتی شد. چارچوبی که مسیر را برای توسعه الگوریتمهایی مانند «برنامهنویسی پویا» (Dynamic Programming) و یادگیری Q هموار کرد و به عاملهای هوشمند اجازه داد تا استراتژیهای بهینهای را با گذشت زمان یاد بگیرند. این روشها در واقع به ابزارهایی برای محققان این حوزه تبدیل شدند و با استفاده از آنها، به بسیاری از چالشهای فرایند تصمیمگیری در موقعیتهای خاص پاسخ داده شد. ترکیب این مفاهیم با یادگیری عمیق، یکی دیگر از پیشرفتهای قابل توجه در تاریخچه یادگیری ماشین است که عاملهای هوشمند را قادر میسازد تا الگوهای موجود در ورودیهای پیچیده را کشف کنند.

ظهور کلان داده و قدرت محاسباتی

افزایش قدرت محاسباتی، تاثیر بزرگی بر توسعه الگوریتمهای یادگیری ماشین در قرن بیستم گذاشت. دورهای قابل توجه از نظر رشد قدرت سختافزارهای در دسترس عموم و ظهور روشهای پردازش موازی.

تاثیر قدرت محاسباتی افزایش یافته

در اواخر قرن بیستم، همزمان با رشد چشمگیر قدرت سختافزاری و محاسباتی، پژوهشگران تحقیقات خود را بر روی مجموعهدادههای بزرگ و مدلهای پیچیده شروع کردند. روشهای پردازش موازی مانند استفاده از پردازشگرهای چند هستهای، باعث شد تا سرعت انجام محسابات چند برابر شود. با این حال، اوایل قرن ۲۱ بود که معرفی «واحدهای پردازنده گرافیکی» (Graphical Processing Units | GPUs)، تحولی دیگر در تاریخچه یادگیری ماشین ایجاد کرد و محسبات موازی در یادگیری ماشین ممکن شد. توسعه مدلهای یادگیری عمیق از سال ۲۰۱۰ به بعد شدت گرفت. مدلهایی که میتوانند از نهایت قدرت محساباتی برای کاربردهایی همچون تشخیص تصویر و «پردازش زبان طبیعی» (Natural Language Processing) استفاده کنند. حالا دیگر با در دسترس قرار گرفتن GPUها و فریمورکهای محاسباتی توزیع شده، پژوهشگران میتوانستند شبکههای عصبی عمیق خود را در بازه زمانی معقول آموزش دهند.

پلتفرمهای ابری مانند Amazon Web Services، Google Cloud و Microsoft Azure، منابع محاسباتی قدرتمندی را در اختیار عموم مردم قرار دادند. قابلیت دسترسیپذیری که سازمانها و اشخاص را قادر میسازد تا بدون نیاز به هزینه اضافه و تهیه سختافزار مناسب، پروژههای یادگیری ماشین خود را اجرا کرده و نتیجه بگیرند. با گذشت زمان، توسعه معماری سختافزارها برای کاربردهایی خاص مانند یادگیری ماشین، بیش از پیش به تاثیر قدرت محاسباتی در یادگیری ماشین شدت بخشیده است. این تحولات در نهایت به کشف الگوریتمهای پیچیدهتر، مجموعهدادههای جامعتر و توسعه کاربردهای بلادرنگ و حقیقی منتهی میشود.

کلان داده

تاریخچه یادگیری ماشین، با تمرکز بر الگوریتمهایی که میتوانند از دادهها یاد بگیرند و نتیجهای را پیشبینی کنند شکل گرفت. در ادامه و همزمان با پیشرفت اینترنت و فناوریهای دیجیتال، عصر «کلان داده» (Big Data) آغاز شد. درک و کار کردن با کلان دادهها برای روشهای یادگیری قدیمی کار پیچیده و دشواری است. از همین جهت «داده کاوی» (Data Mining) بهوجود آمد. حوزهای که تخصص آن در کشف الگوهای موجود، همبستگیها و اطلاعات ارزشمند در مجموعهدادههای بزرگ است. روشهای مختلف داده کاوی ازجمله «خوشهبندی» (Clustering) و روش «یادگیری قواعد وابستگی» (Association Rule Learning)، بهمنظور شناسایی الگوهای پنهان در حجم عظیم دادهها توسعه پیدا کردند. با پیشرفت قدرت محاسباتی، الگوریتمهای یادگیری ماشین به اندازهای تکامل یافتند که میتوانستند بر چالشهای کلان داده غلبه کنند. الگوریتمهایی که مجموعهدادههای بزرگ را به آسانی تحلیل و پردازش میکنند.

ترکیب روشهای رایج در دادهکاوی با الگوریتمهای یادگیری ماشین، عملکرد نهایی سیستمهای هوشمند را بهبود بخشید. به عنوان مثال، از ترکیب روشهای خوشهبندی با مدلهای یادگیری ماشین در «بخشبندی مشتریان» (Customer Segmentation) استفاده میشود. هرچه فرصت یادگیری مدلهای یادگیری ماشین بیشتر باشد و با مجموعهدادههای بزرگتری که در اینترنت فراوان است آموزش ببینند، در زمان کمتری به دقت بالا و عملکرد مناسب میرسند.

شبکه های عصبی و تکامل یادگیری عمیق

تحقیقات اولیه در زمینه شبکههای عصبی از دهه ۴۰ شروع و تا دهه ۶۰ میلادی، بهمنظور تلاشی برای شبیهسازی ساختار مغز انسان و انجام محاسبات پیچیده ادامه داشت. تلاشهایی که در واقع پایهگذار شبکههای عصبی مدرن و یادگیری عمیق بودند. با این حال، تلاشهای اولیه در تاریخچه یادگیری ماشین با چالشهای زیادی روبهرو شدند و به همین خاطر، کمی زمان برد تا سیستمهای هوشمند در دسترس همگان قرار گیرند.

تحقیقات اولیه

در ابتدا شبکههای عصبی ساختاری ساده و تک لایه داشتند که موجب محدودیت میشد. به عنوان مثال، شبکههای پرسپترون نمیتوانستند مسائل را بهصورت خطی جداسازی کنند و در نتیجه، پتانسیل آنها در حل مسائلی که شامل روابط غیرخطی بودند با چالش مواجه میشد. در آن زمان، تنظیم دستی پارامترهای وزنی شبکههای عصبی هنگام فرایند آموزش ضرورت داشت و همین موضوع نیازمند صرف زمان زیادی بود. قابل ذکر است که کمبود مبانی نظری قوی در تحقیقات اولیه این حوزه بسیار به چشم میآمد و معیارهای موفقیت یا شکست مدلهای یادگیری ماشین همچنان ناشناخته بودند. عدم درک کافی از مبانی نظری، مانع دستاوردهای بیشتر در این زمینه شد و از اواخر دهه ۶۰ تا اوایل دهه ۷۰ میلادی، جوامع علمی چندان توجهی به شبکههای عصبی نداشتند.

الگوریتم پس انتشار

الگوریتم «پس انتشار» (Backpropagation)، راهحلی برای مشکلاتی که سد راه پژوهشهای اولیه شده بودند ارائه داد و زمینهساز ورود به عصر یادگیری عمیق شد. الگوریتمی که در دهه ۸۰ میلادی به شهرت رسید، اما معرفی اولیه آن در دهه ۷۰ صورت گرفته بود. ازجمله بزرگترین چالشها، مشکلی بود به نام «محو شدگی گرادیان» (Vanishing Gradients) که در فرایند آموزش شبکههای عمیق اختلال ایجاد میکرد. هنگام بهروزرسانی پارامترهای وزنی شبکه، میزان تغییرات هر وزن، متناسب با مشتق جزئی تابع خاطا نسبت به مقدار وزن فعلی است. مشکل محو شدگی گرادیان زمانی پیش میآید که گرادیان یا همان مشتقها به اندازهای کوچک باشند که دیگر با بهروزرسانی، تغییر چندانی در مقدار وزنها ایجاد نشده و در عمل، فرایند یادگیری شبکه عصبی متوقف میشود. الگوریتم پس انتشار با معرفی سازوکاری برای محاسبه مقادیر گرادیان در جهت معکوس، بهروزرسانی موثر پارامترهای وزنی را از لایه خروجی تا لایه ورودی ممکن ساخت. از این طریق مشکل محو شدگی گرادیان تا حد خوبی کاهش یافته و با جریان یافتن مقادیر گرادیان در طول شبکه عصبی، بهروزرسانی وزنها نیز به خوبی انجام میشود.

در حقیقت با استفاده از الگوریتم پس انتشار، آموزش شبکههای عمیق ممکن شده بود. قابلیتی که در دسترس شبکههای عصبی اولیه قرار نداشت. الگوریتم پس انتشار با بهروزرسانی مقادیر وزنی در لایههای عمیق، باعث بهوجود آمدن ساختارهای چند لایه شد. پیشرفت چشمگیری که حرکت از مدلهای کم عمق ساده به سمت توسعه ساختارهای پیچیده و قابل استفاده را در کاربردهایی مانند تشخیص تصویر و پردازش زبان طبیعی ممکن ساخت. پژوهشگران دریافتند که از طریق مدلهای یادگیری ماشین و با استفاده از الگوریتم پس انتشار، کشف الگوهای پیچیده و دشوار موجود در دادهها به مراتب سادهتر میشود. الگوریتمی که زمینهساز انقلابی در یادگیری عمیق و پیشرفتهای بیشتر در تاریخچه یادگیری ماشین شد.

یادگیری عمیق و شبکه های عصبی پیچشی

سال ۲۰۱۰ آغازگر دستاوردهای یادگیری عمیق است. ازجمله شاخصترین این دستاوردهای میتوان به «شبکههای عصبی پیچشی» (Convolutional Neural Networks | CNNs) اشاره کرد. رویکردی که بهطور کل، نحوه تجزیه و تحلیل تصاویر را در «بینایی ماشین» (Computer Vision) دگرگون کرد. وظیفه یک شبکه عصبی پیچیشی، شناسایی ویژگیهای مهم در تصویر است. لایههای پیچشی از طریق فرایند کانولوشن و با استفاده از فیلترهایی خاص، ویژگیهای مهم را مانند گوشهها و بافت تصاویر شناسایی میکنند. عملی که تا پیش از آن از عهده هیچ نوع مدل محاسباتی برنمیآمد. در مرحله بعد از «لایههای فشردهساز» (Pooling Layers) برای کاهش حجم «بردارهای ویژگی» (Feature Maps) کمک گرفته میشود.

در آخر و با ترکیب ویژگیهای بهدست آمده با «لایههای تمام متصل» (Fully Connected layers)، نتایجی بیسابقه و چشمگیر حاصل میشود. عملکرد بسیار خوب شبکههای عصبی پیچشی در زمینههای همچون «دستهبندی تصاویر» (Image Classification)، «تشخیص اشیاء» (Object Detection)، «ساخت تصویر» (Image Generation) و «یادگیری انتقالی» (Transfer Learning) ثابت شده است.

خط زمانی تاریخچه یادگیری ماشین

امروزه به هر جا که نگاه کنیم، متوجه نوعی از الگوریتمهای یادگیری ماشین میشویم. از موتورهای جستجو گرفته تا اتومبیلهای خودران. پس از بررسی رخدادهای چالشی در تاریخچه یادگیری ماشین، در ادامه این مطلب از مجله فرادرس به تفکیک سال، با برخی از رویدادهای مهم این حوزه آشنا میشویم.

سال ۱۹۴۳: اولین مدل ریاضیاتی از نورون زیستی

نخستین مدل ریاضیاتی توسط «والتر پیتس» (Walter Pitts) و «وارن موکولوچ» (Warren McCulloch) در سال ۱۹۴۳ معرفی شد. روش ارائه شده توسط این پژوهشگران، منجر به ساخت الگوریتمهایی شد که جریان فکری انسان را تقلید میکنند. با وجود محدودیتهای فراوان و نبود رویکردی مشخص برای یادگیری، نورون ارائه شده نقطه شروع بسیار خوبی در تاریخچه یادگیری ماشین و در ادامه یادگیری عمیق و همچنین «یادگیری ماشین کوانتومی» (Quantum Machine Learning) بود.

سال ۱۹۴۹: سیناپس هِب

روانشناس کانادایی «دونالد اولدینگ هب» (Donald O. Hebb) کتاب خود را با عنوان «نظم رفتار: یک نظریه عصبروانشناختی» (The Organization of Behavior: A Neuropsychological Theory) در سال ۱۹۴۹ منتشر کرد. در این کتاب، هب نظریهای درباره تحرک نورونها و ارتباط میان آنها ارائه میدهد. نظریه که دیدگاه روانشناسان را نسبت به فعالیتهای مغزی دگرگون میکند. اولین استفاده این پژوهش در مطالعه نحوه کارکرد مغز بود و به مرور باعث توسعه ماشینهای محاسباتی مانند یادگیری ماشین شد.

سال ۱۹۵۰: تست تورینگ

همانطور که پیشتر نیز با آن آشنا شدیم، تست تورینگ توسط دانشمند کامپیوتر انگلیسی به نام آلن تورینگ، به عنوان معیاری برای سنجش هوش کامپیوتر در سال ۱۹۵۰ معرفی شد. اگر ناظر انسانی نتواند تفاوتی میان صحبت کردن با انسان یا کامپیوتر قائل شود، یعنی کامپیوتر هوشمند است. تست تورینگ بهدلیل دشواری شرایط آزمون و متفاوت بودن معیار هوش برای افراد مختلف، مورد انتقادات زیادی قرار گرفته است. با این حال نمیتوان به عنوان نقطه عطفی در تاریخچه یادگیری ماشین از آن یاد نکرد.

سال ۱۹۵۲: یادگیری ماشین و بازی چکرز

ریاضیدان انگلیسی آرتور ساموئل، نرمافزاری را برای انجام بازی چکرز در سال ۱۹۵۲ بر روی کامپیوتر IBM 701 توسعه داد. آرتور ساموئل مبدع روش «هرس آلفا-بتا» (Alpha-beta Pruning) است؛ رویکری که شانس برنده شدن دو طرف بازی را محاسبه میکند. نرمافزار کامپیوتری ساخته شده از الگوریتم «کمینهبیشینه» (Minimax) برای انتخاب حرکت بعدی استفاده میکند. این قاعده با کمینه کردن «هزینه بیشینه» (Maximum Gain) حریف و بیشنیه کردن «هزینه کمینه» (Minimum Gain) بازیکن، بهترین حرکت را در بازی انتخاب میکند. آرتور ساموئل اولین فردی است که عبارت «یادگیری ماشین» (Machine Learning) را ساخته و به شهرت رساند.

سال ۱۹۵۶: خاستگاه هوش مصنوعی

در تاریخچه یادگیری ماشین، از کارگاه «دارتموث» (Dartmouth) در سال ۱۹۵۶، به عنوان رویدادی بنیادین در هوش مصنوعی یاد میشود. دانشمند علوم کامپیوتر «جان مککارتی» (John McCarthy) ریاضیدانان، دانشمندان و محققان مطرح را به کارگاهی شش تا هشت هفتهای دعوت کرد. این گروه برای همفکری در زمینه هوش مصنوعی و یادگیری ماشین، در کالج دارتموث دور یکدیگر جمع شدند.

سال ۱۹۵۸: پرسپترون

ساخت اولین ماشین قادر به ایدهپردازی و بهدنبال آن طراحی شبکه عصبی پرسپترون یا همان اولین شبکه عصبی تاریخ، توسط روانشناسی به نام «فرانک روزنبلات» (Frank Rosenblatt) انجام شد. روزنبلات مدل دونالد هب از سلولهای مغزی را با روش یادگیری ماشین آرتور ساموئل ترکیب کرد. ورودی سیستم طراحی شده تعدادی «کارت پانچ» (Punch Cards) بود که بعد از ۵۰ دور، میتوانست کارتهای چپ نشانهگذاری شده را از کارتهای راست نشانهگذاری شده تشخیص دهد. بر خلاف آنچه که ادعا میشد، پرسپترون نتوانست درصد بالایی از الگوهای تصویری را شناسایی کند و باعث نا امیدی پژوهشگران شد.

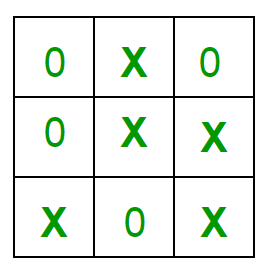

سال ۱۹۶۳: بازی Tic Tac Toe

دانشمند علوم کامپیوتر «دونالد میشل» (Donald Michel)، با ارئه روشی مبتنیبر یادگیری تقویتی، توانست بازی Tic Tac Toe را خودکارسازی کند. این روش عملکردی شبیه به شبکه عصبی دارد. در ابتدا پارامترهای بهطور تصادفی انتخاب شده و پس از چند دور بازی، کامپیوتر یاد میگیرد استراتژیهایی را انتخاب کند که به پیروزی منجر میشوند.

سال ۱۹۶۵: معرفی شبکه های عصبی چند لایه

اولین شبکه پرسپترون چند لایه توسط دو پژوهشگر به نامهای «الکسی ایوکنینکو» (Alexey Ivakhnenko) و «ولنتین لاپا» (Valentin Lapa) در سال ۱۹۶۵ توسعه داده شد. نمایشی سلسلهمراتبی از یک شبکه عصبی که از تابع فعالسازی چندجملهای استفاده میکند. از ایوکنینکو اغلب به عنوان پدر یادگیری عمیق یاد میشود.

سال ۱۹۶۷: الگوریتم نزدیکترین همسایه

مقاله «دستهبندی الگوی نزدیکترین همسایه» (Nearest Neighbor Pattern Classification) توسط «توماس کاور» (Thomas Cover) و «پیتر هارت» (Peter Hart) در سال ۱۹۶۷ منتشر شد. پژوهشی که به نوعی پایهگذار روشهای شناسایی الگو و «رگرسیون» (Regression) در یادگیری ماشین است.

الگوریتم نزدیکترین همسایه روشی بسیار ساده برای شناسایی الگو است که به کامپیوترها اجازه میدهد الگوهایی ابتدایی را تشخیص دهند. در این روش، نمونه ورودی با دادههای موجود مقایسه شده و سپس در شبیهترین گروه قرار میگیرد.

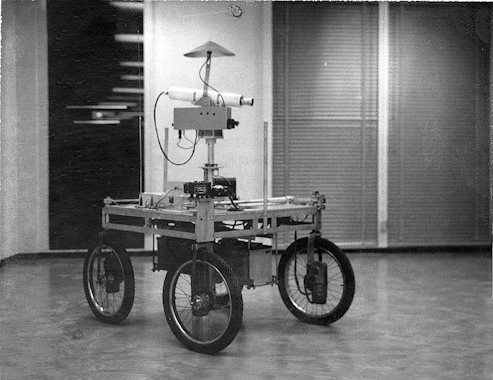

سال ۱۹۷۹: شبکه Neocognitron و ربات Stanford Cart

دانشمند علوم کامپیوتر ژاپنی به نام «کانیکو فوکوشیما» (Kunihiko Fukushima) نتیجه پژوهش خود را در قالب شبکهای چند لایه با عنوان Neocognitron در سال ۱۹۷۹ معرفی کرد. شبکهای که از آن در کاربرد شناسایی الگو استفاده میشد و سپس شبکههای عصبی پیچشی را با الهام از این شبکه طراحی کردند. در همان سال، گروهی از محققان دانشگاه استنفورد رباتی به نام Cart ساختند. کنترل ربات Cart از راه دور بود و با استفاده از کامپیوتری که بر روی آن نصب شده بود، میتوانست در محیطی با موانع بسیار، مسیریابی و حرکت کند. این نوآوری را میتوان به عنوان سرآغازی بر طراحی و ساخت وسایل نقلیه خودران معرفی کرد.

سال ۱۹۸۱: یادگیری مبتنی بر توضیح

یادگیری ماشین، مسیر طولانی را تا شناخته شدنش در سال ۱۹۸۱ طی کرده بود. در این سال، دانشمند علوم کامپیوتر «جرالد دِژانگ» (Gerald Dejong) مفهوم «یادگیری مبتنیبر توضیح» (Explanation Based Learning | EBL) را در تاریخچه یادگیری ماشین تعریف کرد. در این روش، پس از تجزیه و تحلیل دادههای آموزشی و رسیدن به فهم کلی از دادهها، نمونه دادههای بیاهمیت حذف میشوند. به عنوان مثال اگر از نرمافزاری مجهز به این روش خواسته شود در بازی شطرنج بر مهره وزیر تمرکز کند، دیگر مهرههایی که تاثیر فوری بر بازی ندارند، نادیده گرفته میشوند. یادگیری مبتنیبر توضیح را مبنای روشهای «یادگیری نظارت شده» (Supervised Learning) میدانند.

سال ۱۹۸۲: شبکه هاپفیلد

دانشمند آمریکایی به نام «جان هاپفیلد» (John Hopfield) در سال ۱۹۸۲ شبکههای به نام هاپفیلد طراحی کرد. نوعی از شبکه عصبی که خروجی متفاوت با سایر شبکهها نتیجه میدهد. شبکه هاپفیلد یک «حافظه تداعیگر» (Associative Memory) است؛ به این معنی که میتواند الگوهای مختلف را ذخیره و در آینده بهخاطر آورد. شبکه هاپفیلد در آیندهای نه چندان دور، زمینهساز طراحی «شبکههای عصبی بازگشتی» (Recurrent Neural Networks) شد.

سال ۱۹۸۵: شبکه NETTalk

در اواسط دهه ۸۰ میلادی شبکه NETTalk توسط محققان «تری سنافسکی» (Terry Sejnowski) و «چارلز روزنبرگ» (Charles Rosenberg) توسعه داده شد. هدف از این شبکه، ساخت مدلهایی سادهسازی شده بود که فرایند یادگیری مشابه انسان داشتند. به عنوان مثال، با دنبال کردن روشی «دانش-محور» (Knowledge-Driven)، این شبکه نحوه تلفظ واژگان زبان انگلیسی را یاد گرفته و میتواند مانند کودک انسان صحبت کند.

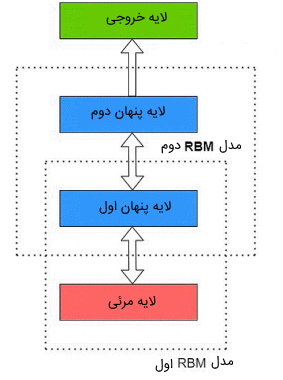

سال ۱۹۸۶: ماشین بولتزمن محدود شده

«ماشین بولتزمن محدود شده» (Restricted Boltzmann Machine | RBM) توسط داشمند علوم شناختی «پاول اسمولنسکی» (Paul Smolensky) در سال ۱۹۸۶ معرفی شد. این رویکرد در اواسط قرن بیستم با معرفی الگوریتمهای «یادگیری سریع» (Fast Learning) توسط دانشمند علوم کامپیوتر «جفری هینتون» (Geoffrey Hinton) و همکاران او به شهرت زیادی رسید. از آنجایی که روش به اصطلاح RBM، ارتباط میان گرهها را محدود میکند، سرعت بیشتری نسبت ماشین بولتزمن قدیمی دارد. از این الگوریتم در «کاهش ابعاد» (Dimensionality Reduction)، «دستهبندی» (Classification)، رگرسیون، «پالایش گروهی» (Collaborative Filtering)، «یادگیری ویژگی» (Feature Learning) و دیگر روشهای مدلسازی استفاده میشود.

سال ۱۹۸۹: مفهوم تقویت در یادگیری ماشین

مفهوم «تقویت» (Boosting) ابتدا در مقالهای با عنوان «توانایی آموزشپذیری ضعیف» (The Strength of Weak Learnability) توسط محققان علوم کامپیوتر «رابرت شاپیره» (Robert Schapire) و «یوواو فرویند» (Yoav Freund) در سال ۱۹۹۰ معرفی شد. تکامل روشهای یادگیری ماشین ازجمله مواردی است که در این مقاله بر آن تاکید شده است. مطابق با روش ارائه شده در این پژوهش، مجموعهای از پیشبینی مدلهای «ضعیف» (Weak) با یکدیگر ترکیب شده و مدلی «قوی» (Powerful) را تشکیل میدهند.

سال ۱۹۹۱: مشکل محو شدگی گرادیان

با وجودی که در شروع دهه ۹۰ میلادی روشهایی همچون «بردارهای ماشین پشتیبان» (Support Vector Machines) معرفی و در دسترس قرار گرفته بودند، همچنان چالشهایی در زمینه یادگیری ماشین وجود داشت. مشکل محو شدگی گرادیان ابتدا توسط دانشمند علوم کامپیوتر آلمانی «سِپ هوچرایتر» (Sepp Hochreiter) معرفی شد. محو شدگی گرادیان مشکلی رایج در فرایند توسعه یادگیری ماشین و بهویژه شبکههای عصبی عمیق است. با افزایش تعداد لایههای یک شبکه، مقدار مشتق پارامترهای وزنی تا جایی کاهش پیدا میکنند که در نهایت به اصطلاح محو میشوند. مشکلی که در یادگیری شبکه عصبی اختلال ایجاد میکند. برای سالهای متوالی، محو شدگی گرادیان چالشی بزرگ برای جامعه هوش مصنوعی بود.

سال ۱۹۹۲: بازی تخته نرد

پژوهشگری به نام «جرالد تِسارو» (Gerald Tesauro) توانست نرمافزاری مبتنیبر شبکههای عصبی مصنوعی طراحی کند که قادر بود بازی «تختهنرد» (Backgammon) را در سطح بازیکنان حرفهای بازی کند. نرمافزاری با عنوان TD-Gammon که میتوانست با تنها چند ساعت آموزش، در سطح بالایی به رقابت با حرفهایها بپردازد. از این نرمافزار به عنوان قدمی مهم در تاریخچه یادگیری ماشین یاد میشود.

سال ۱۹۹۷: دیپ بلو و پیشرفت شبکه های LSTM

در سال ۱۹۹۷، کامپیوتر «دیپ بلو» (Deep Blue) ساخته شرکت IBM، اولین سیستم هوشمندی بود که توانست در سطح بالا رقابت کرده و قهرمان شطرنج «گری کاسپارف» (Garry Kasparov) را شکست دهد. همچنین در همین سال، سپ هوچرایتر و «یورگن اشمیدهابر» (Jürgen Schmidhuber) در مقالهای بسیار مهم، به معرفی شبکههای عصبی با «حافظه کوتاهمدت طولانی» (Long Short-Term Memory | LSTM) پرداختند. نوعی از شبکههای عصبی بازگشتی که آینده یادگیری عمیق را متحول کردند.

سال ۲۰۰۲: انتشار کتابخانه Torch

کتابخانه متنباز یادگیری ماشین به نام Torch در سال ۲۰۰۲ منتشر شد. این کتابخانه قابلیت انعطافپذیری و شخصیسازی بیشتری نسبت به سایر کتابخانه آن زمان داشت و به سرعت تبدیل به یکی از محبوبترین ابزارهای پژوهشگران شد.

سال ۲۰۰۶: شبکه باور عمیق

سال ۲۰۰۶ از اهمیت بالایی در تاریخچه یادگیری ماشین برخوردار است. زیرا در این سال الگوریتمهای یادگیری ماشین سریع توسط جفری هینتون معرفی شدند و دیگر کامپیوترها میتوانستند اشیاء و متون موجود را در تصاویر و ویدئوها شناسایی کنند. همزمان محقق علوم کامپیوتر «راس سالاکودینوف» (Russ Salakhutdinov) و جمعی از همکاران او مقالهای را با عنوان «یک الگوریتم یادگیری سریع برای شبکههای باور عمیق» (A Fast Learning Algorithm For Deep Belief Nets) به چاپ رساندند. در این روش، چند ماشین بولتزمن محدود شده یا RBM در چند لایه بر روی یکدیگر قرار گرفته و شبکههای باور عمیق را تشکیل میدهند.

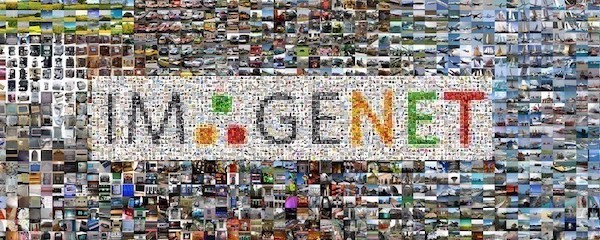

سال ۲۰۰۹: مجموعهداده ImageNet

یکی از اساتید دانشگاه استنفورد به نام «فیفی لی» (Fei-Fei Li) مجموعهدادهای شامل ۱۴ میلیون تصویر برچسبگذاری شده را در سال ۲۰۰۹ منتشر کرد. انتشار این مجموعهداده باعث شد تا پژوهشگران حوزه یادگیری عمیق هر ساله با یکدیگر به رقابت بپردازند و در نهایت، مدلهای یادگیری ماشین دقیقتری حاصل شود. مجله «اکونومیست» (The Economist) از این پایگاه داده به عنوان رخدادی بیمانند در تاریخچه یادگیری ماشین و آغاز شکوفایی شبکههای عمیق یاد میکند.

سال ۲۰۱۰: مایکروسافت کینکت

سال ۲۰۱۰ ازجمله سالهای مهم در تاریخچه یادگیری ماشین است. سالی که در آن «کینکت» (Kinect)، یک سنسور حرکتی برای کنسول بازی «اِکس باکس ۳۶۰» (Xbox 360) منتشر شد. این سنسور میتواند ۲۰ ویژگی مختلف انسان را در ۳۰ فریم بر ثانیه ردیابی کند.

سال ۲۰۱۱: آیبیام واتسون و Google Brain

هوش مصنوعی «واتسون» (Watson) «سیستمی شناختی» (Cognitive System) نیرو گرفته از هوش مصنوعی و پردازش زبان طبیعی است که توسط شرکت IBM توسعه داده شد. هوش مصنوعی واتسون در سال ۲۰۱۱ در برنامهای تلویزیون با عنوان Jeopardy در مقابل دو حریف انسان به رقابت پرداخته و پیروز شد. رویدادی که واستون را به اولین سیستم کامپیوتری تبدیل کرد که توانسته در مسابقهای مقابل انسان به پیروزی برسد.

در همان سال، تیم آزمایشگاهی Google X، الگوریتم یادگیری ماشینی به نام Google Brain معرفی کرد. هدف از ساخت این شبکه عصبی عمیق، یادگیری فرایند مرور ویدئوهای پلتفرم «یوتیوب» (YouTube) و شناسایی تصاویر گربهها مانند مغز انسان بود. این تیم مقاله خود را با عنوان «ساخت ویژگیهای سطح بالا با استفاده از یادگیری نظارت نشده در مقیاس بزرگ» (Building high-level features using large scale unsupervised learning) منتشر کردند. در این مقاله، احتمال آموزش دادن یک «شناساگر چهره» (Face Detector) بدون استفاده از تصاویر برچسبگذاری شده مورد بررسی قرار گرفته است. از این پژوهش به عنوان پیشرفتی چشمگیر در تاریخچه یادگیری ماشین بهویژه «پردازش تصویر» (Image Processing) یاد میشود.

سال ۲۰۱۲: دستهبندی ImageNet

دانشمند علوم کامپیوتر «الکس کریجفسکی» (Alex Krizhevsky) و چند تن از همکاران او، پژوهشی را در سال ۲۰۱۲ منتشر کردند که در آن یک مدل یادگیری ماشین میتوانست درصد خطا را در سیستمهای تشخیص تصویر کاهش دهد. مدل پیچشی مبتنیبر «پردازنده گرافیکی» (Graphics processin unit | GPU) طراحی شده توسط کریجفسکی به نام AlexNet، با دقت ۸۴ درصد برنده رقابت دستهبندی تصویر ImageNet شد. عملکردی که نسبت به دقت ۷۵ درصدی پژوهشهای پیشین چشمگیر بود. از این پیروزی میتوان به عنوان آغازگر انقلابی در یادگیری ماشین یاد کرد.

سال ۲۰۱۴: فیسبوک دیپفیس و گوگل سیبِل

الگوریتم یادگیری عمیق چهره معرفی شده توسط شرکت «فیسبوک» (Facebook) به نام «دیپفیس» (DeepFace)، میتواند افراد را از روی تصویر شناسایی کند. دیپفیس یکی از پیشرفتهترین الگوریتمهای کامپیوتری است که دقتی برابر با ۹۷/۳۵ درصد دارد. حفظ امنیت کاربران، ازجمله کاربردهای این الگوریتم «شناسایی چهره» (Facial Recognition) است که فیسبوک از آن بهره میبرد. انتشار سیستم یادگیری ماشین «گوگل سیبِل» (Google’s Sibyl)، یکی دیگر از نقاط عطف تاریخچه یادگیری ماشین به حساب میآید. این سیستم شامل الگوریتمهای پیچیده بسیاری است که از طریق آنها میتوان به راحتی رفتار انسان را پیشبینی کرد.

سال ۲۰۱۵: پلتفرمی برای الگوریتم های یادگیری ماشین

شرکت «آمازون» (Amazon) در سال ۲۰۱۵ پلتفرم یادگیری ماشین خود را معرفی کرد. با استفاده از یک حساب در «وب سرویس آمازون» (Amazon Web Service | AWS)، هر فردی میتواند از یادگیری ماشین در پروژههای خود استفاده کند. همچنین این پلتفرم مجموعهای از ابزارها و الگوریتمها را برای ساخت و آموزش مدلهای یادگیری ماشین در اختیار دانشمند علم داده قرار میدهد. شرکت «مایکروسافت» (Microsoft) نیز محصولی به نام «مجموعه ابزارهای توزیع شده یادگیری ماشین» (Distributed Machine Learning Toolkit) را توسعه داده است که با استفاده از آن، اشتراکگذاری مسائل یادگیری ماشین در پلتفرمهای مختلف راحت میشود.

سال ۲۰۱۶: الگوریتم آلفاگو و Face2Face

بازی «گو» (Go) یکی از بازیهای سنتی چین است. در این بازی بهدلیل وجود حالتهای حرکتی زیاد در هر مرحله، پیشبینی حرکت بعدی امری دشوار است. شکست دادن یکی از بهترین بازیکنان بازی گو به نام «لی سدول» (Lee Sedol) در سال ۲۰۱۶ توسط الگوریتم «آلفاگو» (AlphaGo)، باعث شگفتی همگان شد. همچنین در همین سال گروهی از دانشمندان، از الگوریتم Face2Face در کنفرانس بینایی ماشین و شناسایی الگو پردهبرداری کردند. عمده سیستمهای «دیپ فیک» (DeepFake) امروزی بر پایه همین الگوریتم پیادهسازی شدهاند.

سال ۲۰۱۷: اتومبیل Waymo

شرکت Waymo ازجمله اولینهایی بود که دست به ساخت اتومبیلهای خودران زد. امروزه اتومبیلهای این شرکت، بدون دخالت انسان چیزی نزدیک به ۵ میلیون مایل رانندگی کردهاند. معرفی تاکسیهای خودران Waymo، پیشرفت مهمی برای این شرکت محسوب میشد و از آن زمان به بعد، روزبهروز به محصولاتش اضافه شده است.

سال ۲۰۱۸: الگوریتم AlphaFold

پس از آلفاگو، طراحی مجموعه الگوریتمها برای پاسخ دادن به مسائلی همچون «تاشدگی پروتئینها» (Protein Folding) به یکی از اهداف تیم DeepMind تبدیل شد. الگوریتم AlphaFold بهمنظور پیشبینی شکل سه بعدی پروتئینها یا همان مولکولهای حیات ساخته شد. تیم DeepMind ابتدا شبکه عصبی را نسبت به هزاران نمونه پروتئین آموزش دادند تا زمانی که بتوانند میان ساختار سه بعدی پروتئینها از «آمینو اسیدها» (Amino Acids) تمایز قائل شوند. مدل یادگیری ماشین نهایی میتوانست فاصله میان جفت آمینو اسیدها و زاویه میان پیوندهای شیمیایی متصلکننده آنها به یکدیگر را پیشبینی کند.

سال ۲۰۲۰: مدل زبانی GPT-3 و حدف کد نویسی

همزمان که دنیا در سال ۲۰۲۰ درگیر همهگیری کرونا بود، شرکت OpenAI الگوریتم یادگیری ماشینی به نام GPT-3 طراحی کرد. مدلی که میتواند متونی شبیه به انسان تولید کند. مدل زبانی GPT-3 یکی از پیشرفتهترین مدلهای زبانی در جهان است که با ۱۷۵ میلیاد پارامتر، از طریق ابرکامپیوترهای هوشمند Microsoft Azure آموزش دیده است. طبق تحقیقات شرکت Zapier، از ابتدای سال ۲۰۲۰، ابزارهای هوشمندی که نیازی به کد نویسی ندارند، محبوبیت زیادی پیدا کردهاند. ازجمله این ابزارهای میتوان به Google AutoML و Amazon SageMaker و Microsoft Azure ML اشاره کرد. ابزارهایی که بدون هیچ دانش کدنویسی میتوان از آنها استفاده کرده و مدلهای یادگیری ماشین خود را آموزش و توسعه دهید. کسبوکارها نیز بهخاطر تولید برنامههای هوشمند سریع و کمهزینه، از این روند حمایت کردهاند.

سال ۲۰۲۱: گروه های تحقیقاتی AI4LIFE و TrustML

دانشمند علوم کامپیوتری هندی به نام «هیما لاکراجو» (Hima Lakkaraju) نه تنها بنیانگذار گروه TrustML است، بلکه مدیریت اجرایی گروه تحقیقاتی AI4LIFE را نیز در دانشگاه هاروارد بر عهده دارد. هدف او در دسترس قرار گرفتن عمومی فناوریهای یادگیری ماشین و بهبود مدلها از منظر تفسیرپذیری و امنیت است.

سال ۲۰۲۲ و آینده یادگیری ماشین

یادگیری ماشین با سرعت زیادی در حال پیشرفت است. در ابتدای سال ۲۰۲۲، دانشگاه استنفورد یادگیری ماشین را به عنوان علمی که کامپیوترها را قادر می سازد بدون برنامهنویسی یاد گرفته و فعالیت کنند، معرفی کرد. در ادامه به بررسی چند نمونه از فناوریهای مورد انتظار در آینده یادگیری ماشین میپردازیم.

یادگیری ماشین کوانتومی

کامپیوترهای کوانتومی با استفاده از الگوریتمهای «یادگیری ماشین کوانتومی» (Quantum Machine Learning | QML) سرعت پردازش و توانایی الگوریتمها را در تجزیه و تحلیل دادهها افزایش میدهند.

الگوریتم های یادگیری نظارت نشده

یادگیری نظارت شده و نظارت نشده اهمیت بالایی در تاریخچه یادگیری ماشین دارند. اما یادگیری نظارت نشده گزینه ایدهآلتری برای شرکتهایی است که هدفشان «بیشفروشی» (Cross-Selling) است.

عملیات یادگیری ماشین

شرکتها با استفاده از «عملیات یادگیری ماشین» (Machine Learning Operations | MLOps)، عملکرد خود را در تولید بهبود میبخشند.

یادگیری ماشین خودکار

با تسهیل فرایند آموزش، «یادگیری ماشین خودکار» (Automated Machine Learning | AutoML) برچسبگذاری دادهها را ممکن ساخته و موجب کاهش خطای انسانی میشود.

اتوماسیون فرایند رباتیکی

پیش از پردازش مسئله، ابتدا باید روشی داده-محور برای «اتوماسیون فرایندهای رباتیکی» (Robotic Process Automations | RPAs) مورد استفاده قرار گیرد. یادگیری ماشین روشی رایج در این زمینه بوده و باعث کاهش تعداد خطاها میشود.

جمعبندی

تاریخچه یادگیری ماشین پر از ایدههای پیشگامانه، نظریههای چشمگیر و نوآوریهایی است که از ابتدا تاکنون تاثیر بسیاری بر قابلیتهای هوش مصنوعی گذاشتهاند. در این مطلب از مجله فرادرس، با دورههای زمانی سخت حوزه هوش مصنوعی آشنا شدیم و به بررسی تاریخچه یادگیری ماشین از ابتدا تا به امروز پرداختیم. همزمان که پژوهشگران و محققان جا پای بزرگان این حوزه میگذارند، کاربرد سیستمهای یادگیری ماشین بیش از پیش در جهان حقیقی نمود پیدا میکند و ما نیز باید خود را برای نوآوریها و پیشرفتهای بیشتر در آینده آماده کنیم.

source